著者:アンドレイ・カルパティ

編集:ティム、PANews

2025年は大規模言語モデルにとって急速な発展と大きな不確実性の年となるでしょう。私たちは実りある成果を達成しました。以下は、私が個人的に注目に値する、そしてやや意外に感じた「パラダイムシフト」です。少なくとも概念的には、状況を変え、私に強い印象を与えた変化です。

1. 検証可能な報酬に基づく強化学習(RLVR)

2025 年初頭には、すべての AI ラボの LLM プロダクション スタックは、おおよそ次の形になります。

- 事前トレーニング(2020年のGPT-2/3)

- 微調整を監督する(InstructGPT 2022)

- そして、人間のフィードバックに基づいた強化学習(RLHF、2022)。

これは長年にわたり、実稼働レベルの大規模言語モデルのトレーニングにおいて、安定した成熟した技術スタックとして機能してきました。2025年までに、検証可能な報酬に基づく強化学習が、主に採用される中核技術となりました。大規模言語モデルを、自動検証可能な報酬(数学やプログラミングの問題解決など)を用いて様々な環境でトレーニングすることで、これらのモデルは人間の「推論」に似た戦略を自発的に形成できるようになります。問題解決を中間計算ステップに分解し、反復的な演繹を通して複数の問題解決戦略を習得することを学習します(DeepSeek-R1論文の例を参照)。従来のスタックでは、大規模言語モデルに最適な推論パスとバックトラッキングメカニズムが明示的ではなかったため、これらの戦略の実装は困難であり、適切な解を見つけるには報酬最適化を通して解を探索する必要がありました。

教師ありファインチューニングや人間からのフィードバックに基づく強化学習(これら2つのフェーズは比較的短く、計算コストも最小限です)とは異なり、検証可能な報酬に基づく強化学習は、客観的でゲーム理論的ではない報酬関数を用いた長期的な最適化学習を伴います。検証可能な報酬に基づく強化学習を実行すると、所定のコストで大幅なパフォーマンス向上が得られることが証明されていますが、その一方で、本来は事前学習用に想定されていた大量の計算リソースを消費します。したがって、2025年における大規模言語モデル機能の進歩は、この新技術によってもたらされる膨大な計算需要を主要なAIラボが吸収することに主に反映されるでしょう。全体として、モデルサイズはほぼ同じままですが、強化学習の学習時間が大幅に延長されていることがわかります。この新技術のもう一つのユニークな点は、全く新しい次元の調整(および対応するスケーリング定理)を獲得したことです。つまり、より長い推論軌跡を生成し、「思考時間」を増やすことで、テスト中の計算コストの関数としてモデル能力を制御できるのです。 OpenAI の o1 モデル (2024 年末にリリース) は検証可能な報酬に基づく強化学習モデルの最初のデモンストレーションでしたが、o3 (2025 年初頭) のリリースは明確な転換点であり、目に見えて大きな飛躍を可能にします。

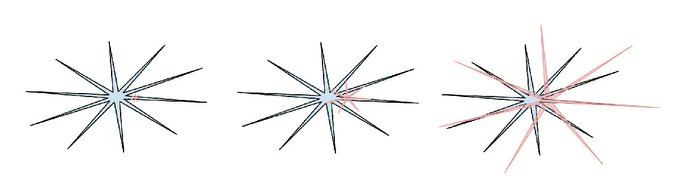

2. 幽霊のような知能 vs. 動物のようなノコギリ歯のような知能

2025年は、私(そしておそらく業界全体)が大規模言語モデル知能の「形」をより直感的な視点から理解し始めた最初の年でした。私たちは「動物を進化させ、繁殖させている」のではなく、「幽霊を召喚している」のです。大規模言語モデルの技術スタック全体(ニューラルアーキテクチャ、学習データ、学習アルゴリズム、そして特に最適化目標)は根本的に異なります。したがって、知能の領域において、生物学的知能とは大きく異なる実体を獲得していることは驚くべきことではありません。動物的な視点からそれらを分析するのは不適切です。教師あり情報の観点から見ると、人間のニューラルネットワークはジャングル環境における部族の生存のために最適化されているのに対し、大規模言語モデルニューラルネットワークは人間の文章を模倣し、数学の問題で報酬を獲得し、アリーナで人間の承認を得るために最適化されています。検証可能な領域が検証可能な報酬に基づく強化学習の条件を提供するにつれて、これらの領域における大規模言語モデルの能力は「突然向上」し、全体的に興味深く、ギザギザしたパフォーマンス特性を示すでしょう。彼らは博学な天才であると同時に、混乱し認知能力に問題のある小学生でもあり、脅迫を受けてあなたのデータを漏洩する可能性があります。

人間の知能:青、AIの知能:赤。このミームのバージョンが気に入っています(Twitterで元の投稿が見つからなくて残念ですが)。人間の知能も独特のギザギザの波模様で現れることを指摘しているからです。

2025年、私は様々なベンチマークに対して無関心と不信感を抱くようになりました。根本的な問題は、ベンチマークは本質的に検証可能な環境であるため、検証可能な報酬や合成データから生成された弱形式に基づく強化学習の影響を非常に受けやすいということです。典型的な「スコア最大化」プロセスでは、大規模な言語モデルチームは必然的にベンチマークの小さな埋め込み空間の近くにトレーニング環境を構築し、これらの領域を「能力のギザギザ」で覆い隠します。「テストセットでのトレーニング」が新たな標準となっています。

では、すべてのベンチマークテストで優勝しても、汎用人工知能を実現できなかったらどうなるのでしょうか?

3. カーソル: LLMアプリケーションのための新しいレイヤー

Cursor について私が最も感銘を受けたのは(今年の急速な成長に加えて)、人々が「XX ドメイン向けの Cursor」といった話題に上り始め、新たな「LLM アプリケーション」の階層構造を説得力を持って明らかにしたことです。今年の Y Combinator での講演で強調したように、Cursor のような LLM アプリケーションの核心は、特定の垂直ドメイン向けの LLM 呼び出しを統合し、オーケストレーションすることにあります。

- 彼らは「コンテキスト エンジニアリング」を担当します。

- 基礎レベルでは、複数の LLM 呼び出しが、パフォーマンスとコストの絶妙なバランスを保ちながら、ますます複雑になる有向非巡回グラフに編成され、アプリケーション固有のグラフィカル インターフェイスが「ヒューマン ループ」内の人々に提供されます。

- また、「自動調整スライダー」も備えています。

2025年までに、この新興アプリケーション層の開発ポテンシャルをめぐっては、広範な議論が交わされてきました。大規模言語モデル・プラットフォームがすべてのアプリケーションを支配するようになるのでしょうか、それとも大規模言語モデル・アプリケーションには依然として大きな可能性が残されているのでしょうか。私の個人的な予測としては、大規模言語モデル・プラットフォームの位置づけは徐々に「ジェネラリスト大学卒業生」の育成へと収束していくでしょう。そして、大規模言語モデル・アプリケーションは、これらの「卒業生」を組織化し、洗練させ、プライベートデータ、センサー、アクチュエーター、フィードバックループを提供することで、彼らが特定の垂直分野に展開できる真の「プロフェッショナルチーム」へと成長していくことを担うようになるでしょう。

4. クロード・コード: ローカルで実行されるAI

Claude Codeの登場は、ツールの使用と推論プロセスを循環的に組み合わせることで、より永続的で複雑な問題解決を実現するLLMエージェントの形態を初めて説得力を持って示しました。さらに、Claude Codeで私が最も感銘を受けたのは、それがユーザーのパーソナルコンピュータ上で動作し、ユーザーのプライベートな環境、データ、コンテキストと深く統合されていることです。OpenAIのこの方向性に関する評価には多少の欠陥があると思います。彼らはコードアシスタントとエージェントの開発を、ローカルのローカルホスト環境ではなく、クラウド展開、具体的にはChatGPTによってオーケストレーションされたコンテナ化された環境に重点を置いているからです。クラウドで実行されるエージェントクラスターは「汎用人工知能の究極の形」を体現しているように見えますが、現在は機能開発の不均一性と比較的遅い進歩が特徴的な過渡期にあります。このような状況下では、エージェントをローカルコンピュータに直接展開し、開発者とその特定の作業環境と密接に連携させる方が、より論理的な道筋と言えるでしょう。クロード・コードはこの優先事項を正確に把握し、簡潔でエレガント、そして非常に魅力的なコマンドラインツールにカプセル化することで、AIの提示方法を根本から変革しました。AIはもはやGoogleのようなウェブサイトにアクセスするだけでなく、コンピュータ内に「常駐」する小さなスプライトやゴーストのようなものなのです。これは、AIとインタラクションするための全く新しい、独自のパラダイムです。

5. Vibe Coding - プログラミング環境

2025年までに、AIは臨界的な能力の閾値を超え、英語の記述のみで、基盤となるコードを理解することさえ必要とせずに、素晴らしいプログラムを構築できるようになるでしょう。興味深いことに、私はシャワーを浴びている最中に何気なくツイートした言葉から「バイブコーディング」という言葉を思いつきました。それが現在の形に進化するとは想像もしていませんでした。バイブコーディングのパラダイムにおいて、プログラミングはもはや高度な訓練を受けた専門家に限定されるものではなく、誰もが参加できるものになります。この観点から見ると、これは私が記事「人々に力を与える:大規模言語モデルが技術普及パターンをどのように変えるか」で述べた現象のもう一つの例です。これまでの他のすべての技術とは対照的に、大規模言語モデルから恩恵を受けるのは、専門家、企業、政府よりも一般の人々です。しかし、バイブコーディングは一般の人々がプログラミングにアクセスできるようにするだけでなく、プロの開発者が「そうでなければ決して実装されなかったであろう」ソフトウェアをより多く作成できるようにします。 nanochatの開発中、Vibe Codingを使って、既存のライブラリに頼ったり、Rustを深く掘り下げたりすることなく、Rustでカスタムの効率的なBPEトークナイザーを作成しました。今年は、Vibe Codingを使っていくつかのプロジェクトのプロトタイプを素早く作成し、特定のアイデアの実現可能性を確認しました。特定の脆弱性を特定するためだけに、一度限りのアプリケーションを丸ごと書いたこともあります。なぜなら、コードは突如として無料、短命、柔軟、そして使い捨てになるからです。雰囲気プログラミングはソフトウェア開発のエコシステムを再構築し、キャリアの定義の境界を大きく変えるでしょう。

6. Nano Banana: LLMグラフィカルインターフェース

GoogleのGemini Nanoバナナは、2025年における最も破壊的なパラダイムシフトの一つです。私見では、大規模言語モデル(LLM)は、1970年代と80年代のコンピュータに続く、次世代の主要なコンピューティングパラダイムを代表するものです。したがって、パーソナルコンピューティング、マイクロコントローラ、そしてインターネットの進化と同様に、同様の根本的な理由に基づく同様のイノベーションが今後見られるでしょう。特に人間とコンピュータのインタラクションのレベルでは、LLMを用いた現在の「対話」モードは、1980年代のコンピュータ端末へのコマンド入力に似ています。テキストはコンピュータ(そしてLLM)にとって最も原始的なデータ表現形式ですが、人間にとっては好ましい方法ではありません(特に入力時)。人間は実際にはテキストを読むことを嫌います。それは時間がかかり、面倒だからです。人間はむしろ、視覚的および空間的な次元を通して情報を受け取ることを好みます。そのため、従来のコンピューティングにおいてグラフィカルユーザーインターフェース(GUI)が誕生したのです。同様に、大規模言語モデルは、画像、インフォグラフィック、スライド、ホワイトボード、アニメーション、動画、ウェブアプリケーション、その他のメディアなど、人間が好む形式でコミュニケーションをとるべきです。初期の形態では、絵文字やマークダウンといった「視覚的なテキスト装飾」(見出し、太字、リスト、表、その他のタイポグラフィ要素など)によって既にこれが実現されています。しかし、大規模言語モデルのグラフィカルインターフェースを最終的に構築するのは誰でしょうか?この観点から見ると、ナノバナナは、この未来の青写真の初期プロトタイプです。ナノバナナの画期的な点は、画像生成機能だけでなく、テキスト生成、画像生成、そしてモデルの重みにおける世界知識を織り交ぜることで形成される包括的な機能にある点にもあることは注目に値します。