強化學習× Web3 的真正機會不在於複製一個去中心化版OpenAI,而在於重寫「智慧生產關係」

撰文:0xjacobzhao

本獨立研報由IOSG Ventures支持,研究與寫作過程受Sam Lehman(Pantera Capital) 強化學習研報的啟發,感謝Ben Fielding (Gensyn.ai), Gao Yuan(Gradient), Samuel Dare & Erfan Miahi (Covenant AI), Shashank Yadav (Fraction AI), Chao Wang 對本文提出的寶貴建議。本文力求內容客觀準確,部分觀點涉及主觀判斷,難免有偏差,敬請讀者理解。

人工智慧正從以「模式擬合」為主的統計學習,邁向以「結構化推理」為核心的能力體系,後訓練(Post-training)的重要性快速上升。 DeepSeek-R1 的出現標誌著強化學習在大模型時代的範式級翻身,行業共識形成:預訓練構建模型的通用能力基座,強化學習不再只是價值對齊工具,而被證明能夠系統提升推理鏈質量與複雜決策能力,正逐步演化為持續提升智能水平的技術路徑。

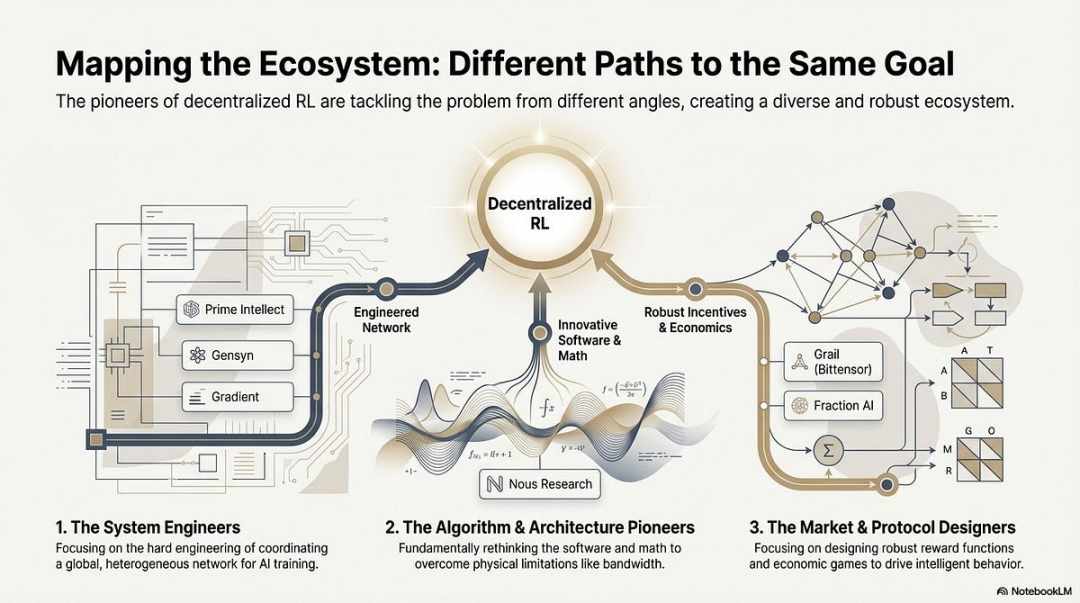

同時,Web3 正透過去中心化算力網路與加密激勵體系重構AI 的生產關係,而強化學習對rollout 採樣、獎勵訊號與可驗證訓練的結構性需求,恰與區塊鏈的算力協作、激勵分配與可驗證執行天然契合。本研究將系統拆解AI 訓練範式與強化學習技術原理,論證強化學習× Web3 的結構優勢,並對Prime Intellect、Gensyn、Nous Research、Gradient、Grail 和Fraction AI 等項目進行分析。

一. AI 訓練的三個階段:預訓練、指令微調與後訓練對齊

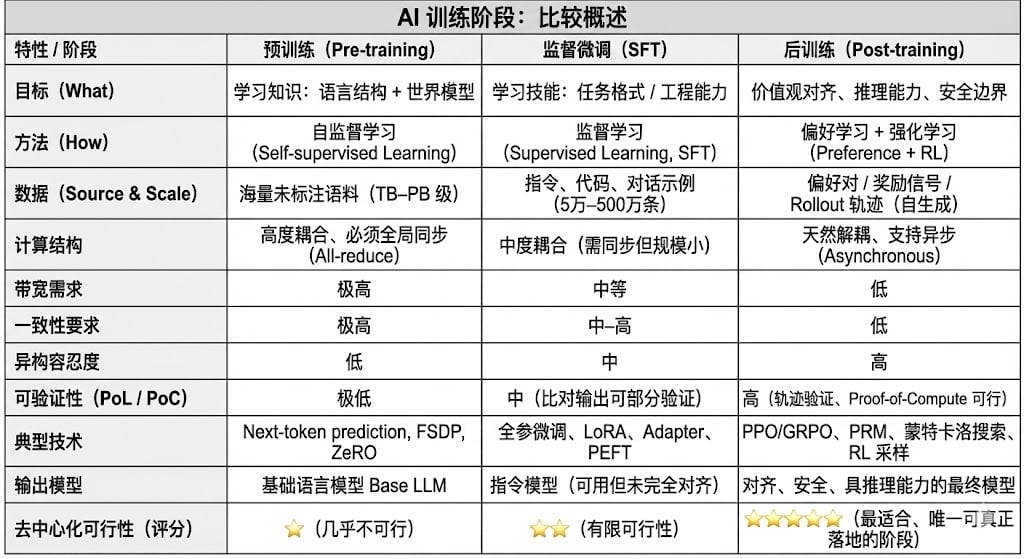

現代大語言模型(LLM)訓練全生命週期通常被劃分為三個核心階段:預訓練(Pre-training)、監督微調(SFT)和後訓練(Post-training/RL)。三者分別承擔「建構世界模型—注入任務能力—塑造推理與價值」的功能,其計算結構、資料需求與驗證難度決定了去中心化的匹配程度。

預訓練(Pre-training) 透過大規模自監督學習(Self-supervised Learning)建構模型的語言統計結構與跨模態世界模型,是LLM 能力的根基。此階段需在萬億級語料上以全局同步方式訓練,依賴數千至數萬張H100 的同構集群,成本佔比高達80–95%,對頻寬與資料版權極度敏感,因此必須在高度集中式環境中完成。

微調(Supervised Fine-tuning)用於注入任務能力與指令格式,資料量小、成本佔比約5–15%,微調既可以進行全參訓練,也可以採用參數高效微調(PEFT)方法,其中LoRA、Q-LoRA 與Adapter 是工業界主流。但仍需同步梯度,使其去中心化潛力有限。

後訓練(Post-training)由多個迭代子階段構成,決定模型的推理能力、價值觀與安全邊界,其方法既包括強化學習體系(RLHF、RLAIF、GRPO)也包括無RL 的偏好最佳化方法(DPO),以及過程獎勵模型(PRM)等。此階段資料量與成本較低(5–10%),主要集中在Rollout 與策略更新;其天然支援非同步與分散式執行,節點無需持有完整權重,結合可驗證計算與鏈上激勵可形成開放的去中心化訓練網絡,是最適配Web3 的訓練環節。

二. 強化學習技術全景:架構、框架與應用2.1 強化學習的系統架構與核心環節

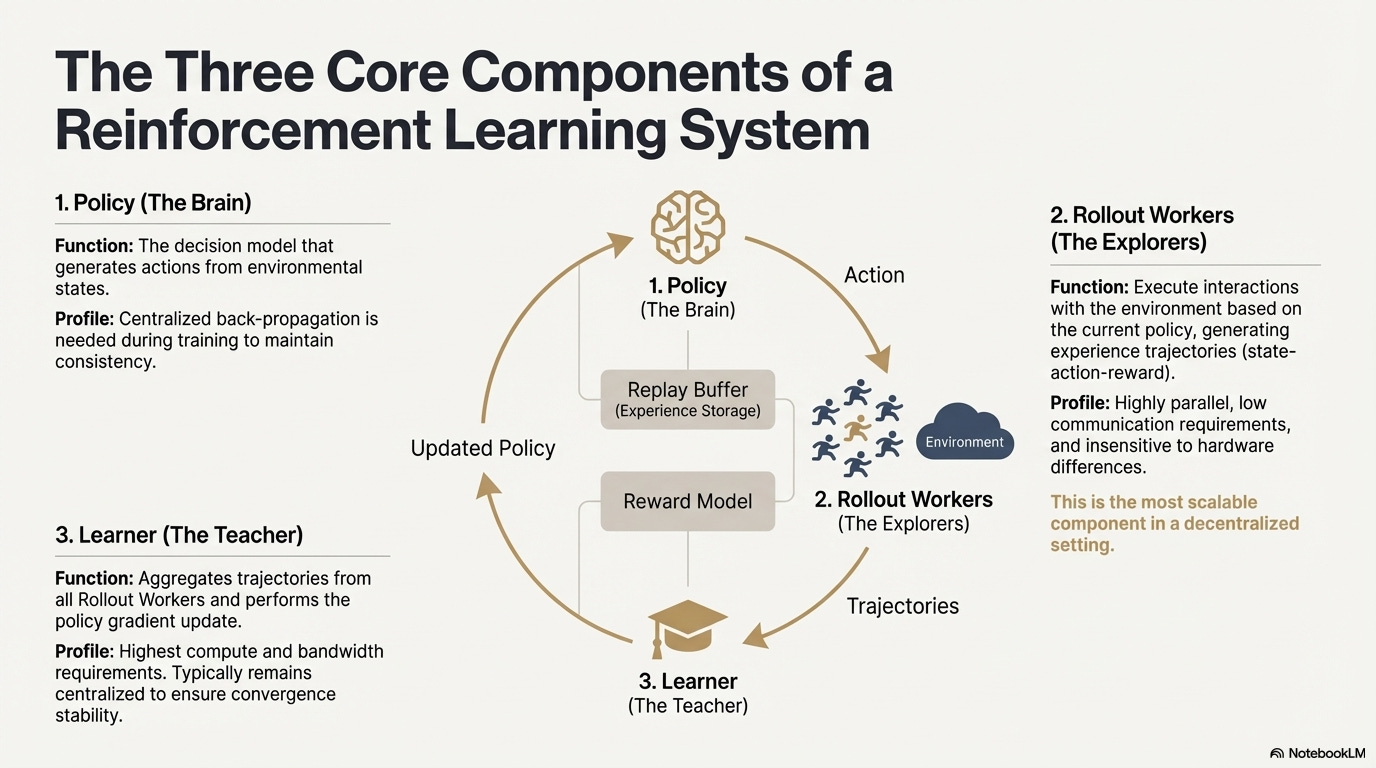

強化學習(Reinforcement Learning, RL)透過「環境互動—獎勵回饋—策略更新」驅動模型自主改善決策能力,其核心結構可視為由狀態、動作、獎勵與策略所構成的回饋閉環。一個完整的RL 系統通常包含三類元件:Policy(策略網路)、Rollout(經驗採樣)與Learner(策略更新器)。策略與環境互動產生軌跡,Learner 根據獎勵訊號更新策略,從而形成持續迭代、不斷優化的學習過程:

策略網絡(Policy):從環境狀態產生動作,是系統的決策核心。訓練時需集中式反向傳播維持一致性;推理時可分送至不同節點並行運作。

經驗採樣(Rollout):節點根據策略執行環境交互,產生狀態—動作—獎勵等軌跡。過程高度並行、通訊極低,對硬體差異不敏感是最適合在去中心化中擴展的環節。

學習器(Learner):聚合全部Rollout 軌跡並執行策略梯度更新,是唯一對算力、頻寬要求最高的模組,因此通常保持中心化或輕中心化部署以確保收斂穩定性。

2.2 強化學習階段架構(RLHF → RLAIF → PRM → GRPO)

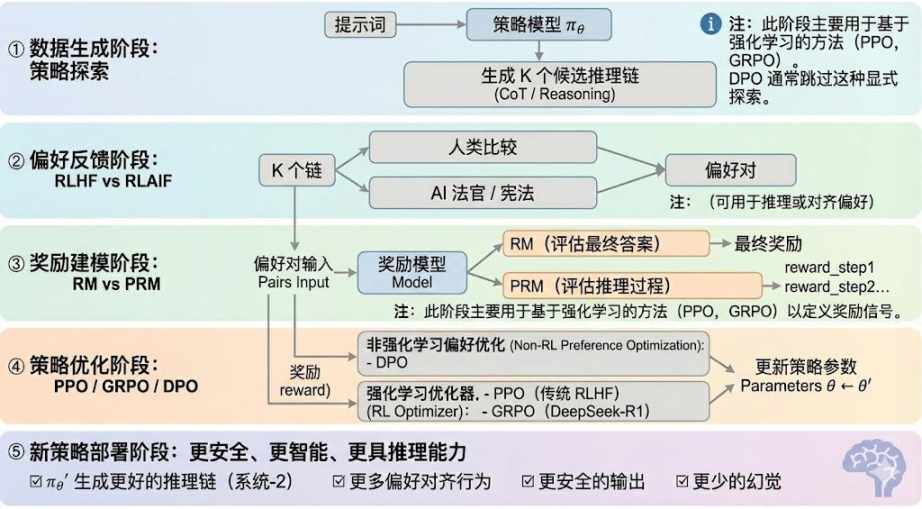

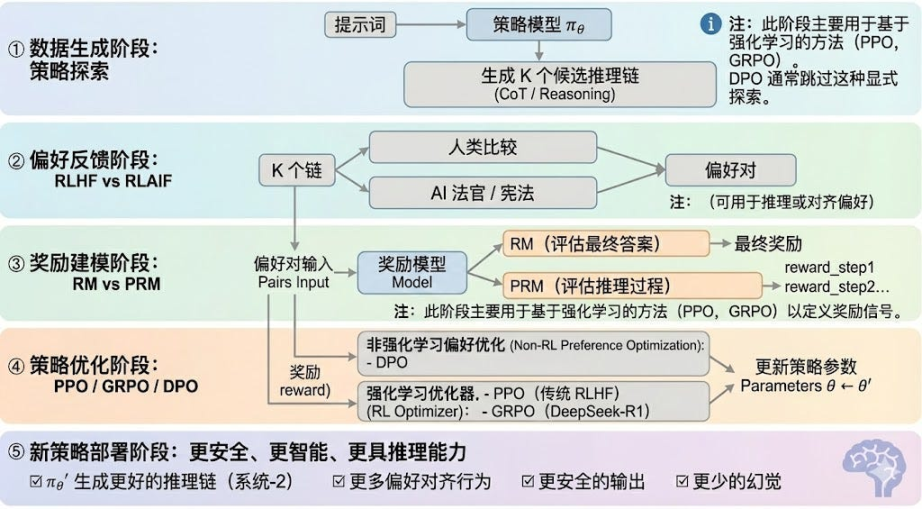

強化學習通常可分為五個階段,整體流程如下所述:

資料產生階段(Policy Exploration):在給定輸入提示的條件下,策略模型πθ 產生多個候選推理鍊或完整軌跡,為後續偏好評估與獎勵建模提供樣本基礎,決定了策略探索的廣度。

偏好回饋階段(RLHF / RLAIF):

RLHF(Reinforcement Learning from Human Feedback)透過多候選回答、人工偏好標註、訓練獎勵模型(RM)並以PPO 優化策略,使模型輸出更符合人類價值觀,是GPT-3.5 → GPT-4 的關鍵一環

RLAIF(Reinforcement Learning from AI Feedback)以AI Judge 或憲法式規則取代人工標註,實現偏好獲取自動化,顯著降低成本並具備規模化特性,已成為Anthropic、OpenAI、DeepSeek 等的主流對齊範式。

獎勵建模階段(Reward Modeling):偏好對輸入獎勵模型,學習將輸出對應為獎勵。 RM 教導模型「什麼是正確答案」,PRM 教導模型「如何進行正確推理」。

RM(Reward Model)用於評估最終答案的好壞,僅對輸出評分:

過程獎勵模型PRM(Process Reward Model)它不再只評估最終答案,而是為每一步推理、每個token、每個邏輯段評分,也是OpenAI o1 與DeepSeek-R1 的關鍵技術,本質上是在「教模型如何思考」。

獎勵驗證階段(RLVR / Reward Verifiability):在獎勵訊號產生與使用過程中引入「可驗證約束」,使獎勵盡可能來自可複現的規則、事實或共識,從而降低reward hacking 與偏差風險,並提昇在開放環境中的可審計性與可擴展性。

策略最佳化階段(Policy Optimization):是在獎勵模型給出的訊號指導下更新策略參數θ,以獲得更強推理能力、更高安全性與更穩定行為模式的策略πθ′。主流優化方式包括:

PPO(Proximal Policy Optimization): RLHF 的傳統優化器,以穩定性見長,但在複雜推理任務中往往面臨收斂慢、穩定性不足等限制。

GRPO(Group Relative Policy Optimization):是DeepSeek-R1 的核心創新,透過對候選答案組內優勢分佈進行建模以估計期望價值,而非簡單排序。此方法保留了獎勵幅度訊息,更適合推理鏈優化,訓練過程更穩定,被視為繼PPO 之後面向深度推理場景的重要強化學習優化框架。

DPO(Direct Preference Optimization):非強化學習的後訓練方法:不產生軌跡、不建造獎勵模型,而是直接在偏好對上做優化,成本低、效果穩定,因而被廣泛用於Llama、Gemma 等開源模型的對齊,但不提升推理能力。

新策略部署階段(New Policy Deployment):經過最佳化後的模型表現為:更強的推理鏈生成能力(System-2 Reasoning)、更符合人類或AI 偏好的行為、更低的幻覺率、更高的安全性。模型在持續迭代中不斷學習偏好、最佳化過程、提升決策質量,形成閉環。

2.3 強化學習的產業應用五大分類

強化學習(Reinforcement Learning)已從早期的博弈智慧演進為跨產業的自主決策核心框架,其應用場景按照技術成熟度與產業落地程度,可歸納為五大類別,並在各自方向推動了關鍵突破。

博弈與策略系統(Game & Strategy):是RL 最早被驗證的方向,在AlphaGo、AlphaZero、AlphaStar、OpenAI Five 等「完美資訊+ 明確獎勵」的環境中,RL 展示了可與人類專家比肩甚至超越的決策智能,為現代RL 演算法奠定基礎。

機器人與具身智慧(Embodied AI):RL 透過連續控制、動力學建模與環境交互,使機器人學習操控、運動控制和跨模態任務(如RT-2、RT-X),正快速邁向產業化,是現實世界機器人落地的關鍵技術路線。

數字推理(Digital Reasoning / LLM System-2):RL + PRM 推動大模型從「語言模仿」走向「結構化推理」,代表成果包括DeepSeek-R1、OpenAI o1/o3、Anthropic Claude 及AlphaGeometry,其本質是在推理鏈層面進行獎勵優化,而非僅評估最終獎勵答案。

自動化科學發現與數學優化(Scientific Discovery):RL 在無標籤、複雜獎勵與巨大搜尋空間中尋找最優結構或策略,已實現AlphaTensor、AlphaDev、Fusion RL 等基礎突破,展現出超越人類直覺的探索能力。

經濟決策與交易系統(Economic Decision-making & Trading):RL 被用於策略優化、高維度風險控制與自適應交易系統生成,相較傳統量化模型更能在不確定環境中持續學習,是智慧金融的重要組成部分。

三. 強化學習與Web3 的自然匹配

強化學習(RL)與Web3 的高度契合,源自於二者本質上都是「激勵驅動系統」。 RL 依賴獎勵訊號優化策略,區塊鏈依靠經濟激勵協調參與者行為,使兩者在機制層面天然一致。 RL 的核心需求——大規模異質Rollout、獎勵分配與真實性驗證——正是Web3 的結構優勢所在。

推理與訓練解耦:強化學習的訓練過程可明確分割為兩個階段:

Rollout ( 探索採樣):模型基於當前策略產生大量數據,計算密集型但通訊稀疏型的任務。它不需要節點間頻繁通信,適合在全球分佈的消費級GPU 上並行產生。

Update ( 參數更新):基於收集到的資料更新模型權重,需高頻寬中心化節點完成。

「推理—訓練解耦」天然契合去中心化的異構算力結構:Rollout 可外包給開放網絡,透過代幣機制按貢獻結算,而模型更新保持集中化以確保穩定性。

可驗證性(Verifiability):ZK 與Proof-of-Learning 提供了驗證節點是否真實執行推理的手段,解決了開放網路中的誠實性問題。在程式碼、數學推理等確定性任務中,驗證者只需檢查答案即可確認工作量,大幅提升去中心化RL 系統的可信度。

激勵層,基於代幣經濟的反饋生產機制:Web3 的代幣機制可直接獎勵RLHF/RLAIF 的偏好反饋貢獻者,使偏好數據生成具備透明、可結算、無需許可的激勵結構;質押與削減(Staking/Slashing)進一步約束反饋質量,形成比傳統眾包更高效且對齊的反饋市場。

多智能體強化學習(MARL)潛力:區塊鏈本質上是公開、透明、持續演化的多智能體環境,帳戶、合約與智能體不斷在激勵驅動下調整策略,使其天然具備建構大規模MARL 實驗場的潛力。儘管仍在早期,但其狀態公開、執行可驗證、激勵可編程的特性,為未來MARL 的發展提供了原則性優勢。

四. 經典Web3 + 強化學習項目解析

基於上述理論框架,我們將對當前生態中最具代表性的項目進行簡要分析:

Prime Intellect: 非同步強化學習範式prime-rl

Prime Intellect 致力於建構全球開放算力市場,降低訓練門檻、推動協作式去中心化訓練,並發展完整的開源超級智慧技術堆疊。其係統包括:Prime Compute(統一雲/ 分散式算力環境)、INTELLECT 模型家族(10B–100B+)、開放強化學習環境中心(Environments Hub)、以及大規模合成資料引擎(SYNTHETIC-1/2)。

Prime Intellect 核心基礎設施元件prime-rl 架構專為非同步分散式環境設計與強化學習高度相關,其餘包括突破頻寬瓶頸的OpenDiLoCo 通訊協定、保障運算完整性的TopLoc 驗證機制等。

Prime Intellect 核心基礎架構元件一覽

技術基石:prime-rl 非同步強化學習框架

prime-rl 是Prime Intellect 的核心訓練引擎,專為大規模非同步去中心化環境設計,透過Actor–Learner 完全解耦實現高吞吐推理與穩定更新。執行者(Rollout Worker) 與學習者(Trainer) 不再同步阻塞,節點可隨時加入或退出,只需持續拉取最新策略並上傳產生資料:

執行者Actor (Rollout Workers):負責模型推理和資料產生。 Prime Intellect 創新地在Actor 端整合了vLLM 推理引擎。 vLLM 的PagedAttention 技術和連續批次(Continuous Batching)能力,使得Actor 能夠以極高的吞吐量產生推理軌跡。

學習者Learner (Trainer):負責策略優化。 Learner 從共享的經驗回放緩衝區(Experience Buffer)中非同步拉取資料進行梯度更新,無需等待所有Actor 完成目前批次。

協調器(Orchestrator):負責調度模型權重與資料流。

prime-rl 的關鍵創新點:

完全非同步(True Asynchrony):prime-rl 摒棄傳統PPO 的同步範式,不等待慢節點、無需批次對齊,使任意數量與效能的GPU 都能隨時接入,奠定去中心化RL 的可行性。

深度整合FSDP2 與MoE:透過FSDP2 參數切片與MoE 稀疏激活,prime-rl 讓百億級模型在分散式環境中高效訓練,Actor 僅運行活躍專家,大幅降低顯存與推理成本。

GRPO+(Group Relative Policy Optimization):GRPO 免除Critic 網絡,顯著減少計算與顯存開銷,天然適配異步環境,prime-rl 的GRPO+ 更透過穩定化機制確保高延遲條件下的可靠收斂。

INTELLECT 模型家族:去中心化RL 技術成熟度的標誌

INTELLECT-1(10B,2024 年10 月)首次證明OpenDiLoCo 能在跨三大洲的異構網路中高效訓練(通訊佔比<2%、算力利用率98%),打破跨地域訓練的物理認知;

INTELLECT-2(32B,2025 年4 月)作為第一個Permissionless RL 模型,驗證prime-rl 與GRPO+ 在多步驟延遲、非同步環境中的穩定收斂能力,實現全球開放算力參與的去中心化RL;

INTELLECT-3(106B MoE,2025 年11 月)採用僅激活12B 參數的稀疏架構,在512×H200 上訓練並實現旗艦級推理性能(AIME 90.8%、GPQA 74.4%、MMLU-Pro 81.9% 等),整體表現已大於自身的中心甚至超越規模遠化源模型。

Prime Intellect 另外也建構了數個支撐性基礎設施:OpenDiLoCo 透過時間稀疏通訊與量化權重差,將跨地域訓練的通訊量降低數百倍,使INTELLECT-1 在跨三洲網路仍保持98% 使用率;TopLoc + Verifiers 形成去中心化執行層,以驗證指紋與沙箱驗證指紋資料引擎則生產大規模高品質推理鏈,並透過管線並行讓671B 模型在消費級GPU 叢集上高效運作。這些組件為去中心化RL 的資料產生、驗證與推理吞吐提供了關鍵的工程底座。 INTELLECT 系列證明了這個技術堆疊可產生成熟的世界級模型,標誌著去中心化訓練系統從概念階段進入實用階段。

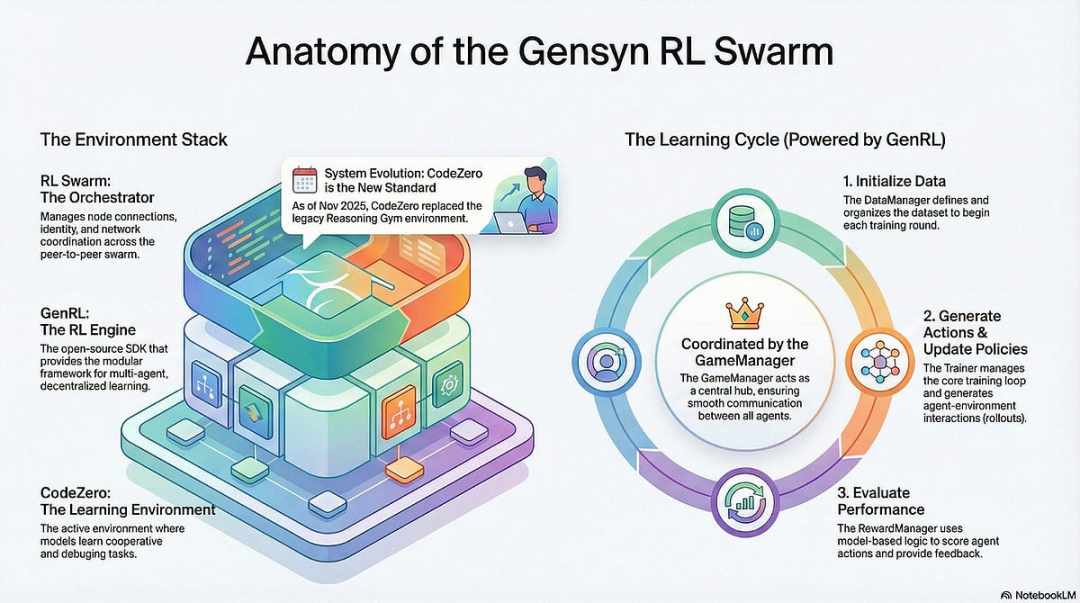

Gensyn: 強化學習核心堆疊RL Swarm 與SAPO

Gensyn 的目標是將全球閒置算力匯集成一個開放、無需信任、可無限擴展的AI 訓練基礎設施。其核心包括跨裝置標準化執行層、點對點協調網路與無需信任的任務驗證系統,並透過智慧合約自動分配任務與獎勵。圍繞著強化學習的特點,Gensyn 引入RL Swarm、SAPO 與SkipPipe 等核心機制等機制,將生成、評估、更新三個環節解耦,利用全球異構GPU 組成的「蜂群」實現集體演化。其最終交付的不是單純的算力,而是可驗證的智慧(Verifiable Intelligence)。

Gensyn 堆疊的強化學習應用

RL Swarm:去中心化的協作式強化學習引擎

RL Swarm 展示了一種全新的協作模式。它不再是簡單的任務分發,而是一個模擬人類社會學習的去中心化的「生成—評估—更新」循環,類比協作式學習過程,無限循環:

Solvers(執行者): 負責本地模型推理與Rollout 生成,節點異質無礙。 Gensyn 在本地整合高吞吐推理引擎(如CodeZero),可輸出完整軌跡而非僅答案。

Proposers(出題者): 動態生成任務(數學題、程式碼問題等),支援任務多樣性與類別Curriculum Learning 的難度自適應。

Evaluators(評估者): 使用凍結的「裁判模型」或規則對本地Rollout 進行評估,產生本地獎勵訊號。評估過程可被審計,減少作惡空間。

三者共同組成一個P2P 的RL 組織結構,無需中心化調度即可完成大規模協作學習。

SAPO:為去中心化重構的策略最佳化演算法: SAPO(Swarm Sampling Policy Optimization)以「共享Rollout 並過濾無梯度訊號樣本,而非共享梯度」為核心,透過大規模去中心化的Rollout 取樣,並將接收的Rollout 視為本地生成,從而在無中心協調、延遲延遲的環境中保持差異收斂。相較依賴Critic 網路、運算成本較高的PPO,或基於組內優勢估計的GRPO,SAPO 以極低頻寬使消費級GPU 也能有效參與大規模強化學習最佳化。

透過RL Swarm 與SAPO,Gensyn 證明了強化學習(尤其是後訓練階段的RLVR)自然適配去中心化架構——因為其更依賴於大規模、多樣化的探索(Rollout),而非高頻參數同步。結合PoL 與Verde 的驗證體系,Gensyn 為萬億級參數模型的訓練提供了一條不再依賴單一科技巨頭的替代路徑:一個由全球數百萬異構GPU 組成的、自我演化的超級智慧網路。

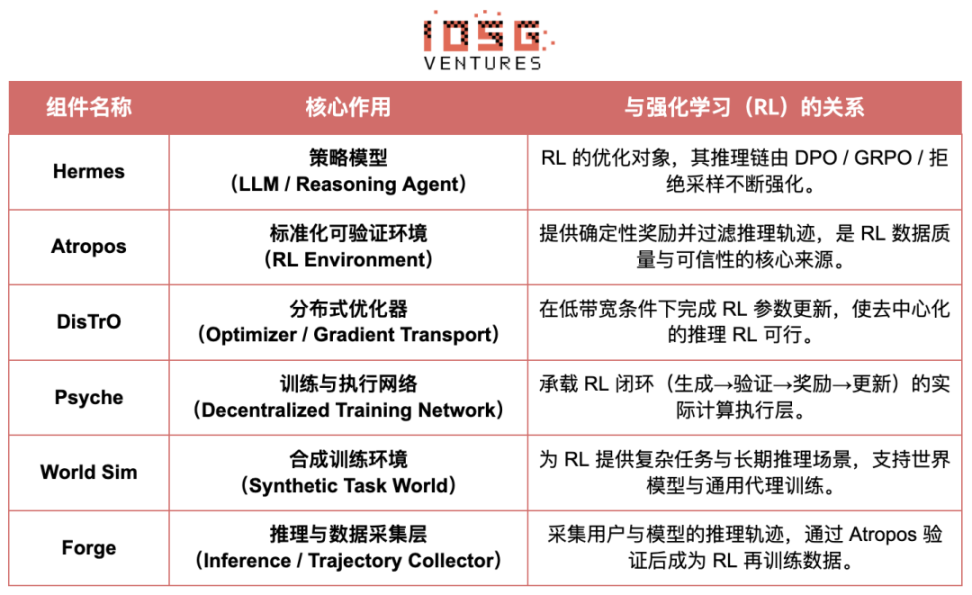

Nous Research:可驗證強化學習環境Atropos

Nous Research 在建構一套去中心化、可自我進化的認知基礎設施。其核心元件-Hermes、Atropos、DisTrO、Psyche 與World Sim 被組織成一個持續閉環的智慧演化系統。有別於傳統「預訓練—後訓練—推理」線性流程,Nous 採用DPO、GRPO、拒絕採樣等強化學習技術,將資料產生、驗證、學習與推理統一為連續回饋迴路,打造持續自我改進的閉環AI 生態。

Nous Research 組件總覽

模型層:Hermes 與推理能力的演進

Hermes 系列是Nous Research 面向用戶的主要模型接口,其演進清晰展示了行業從傳統SFT/DPO 對齊向推理強化學習(Reasoning RL)遷移的路徑:

Hermes 1–3:指令對齊與早期代理能力:Hermes 1–3 依靠低成本DPO 完成穩健指令對齊,並在Hermes 3 借助合成數據與首次引入的Atropos 驗證機制。

Hermes 4 / DeepHermes:透過思考鏈將System-2 式慢思考寫入權重,以Test-Time Scaling 提升數學與程式碼效能,並依賴「拒絕取樣+ Atropos 驗證」建構高純度推理資料。

DeepHermes 進一步採用GRPO 取代難以分散式落地的PPO,使推理RL 能在Psyche 去中心化GPU 網路上運行,為開源推理RL 的可擴展化奠定工程基礎。

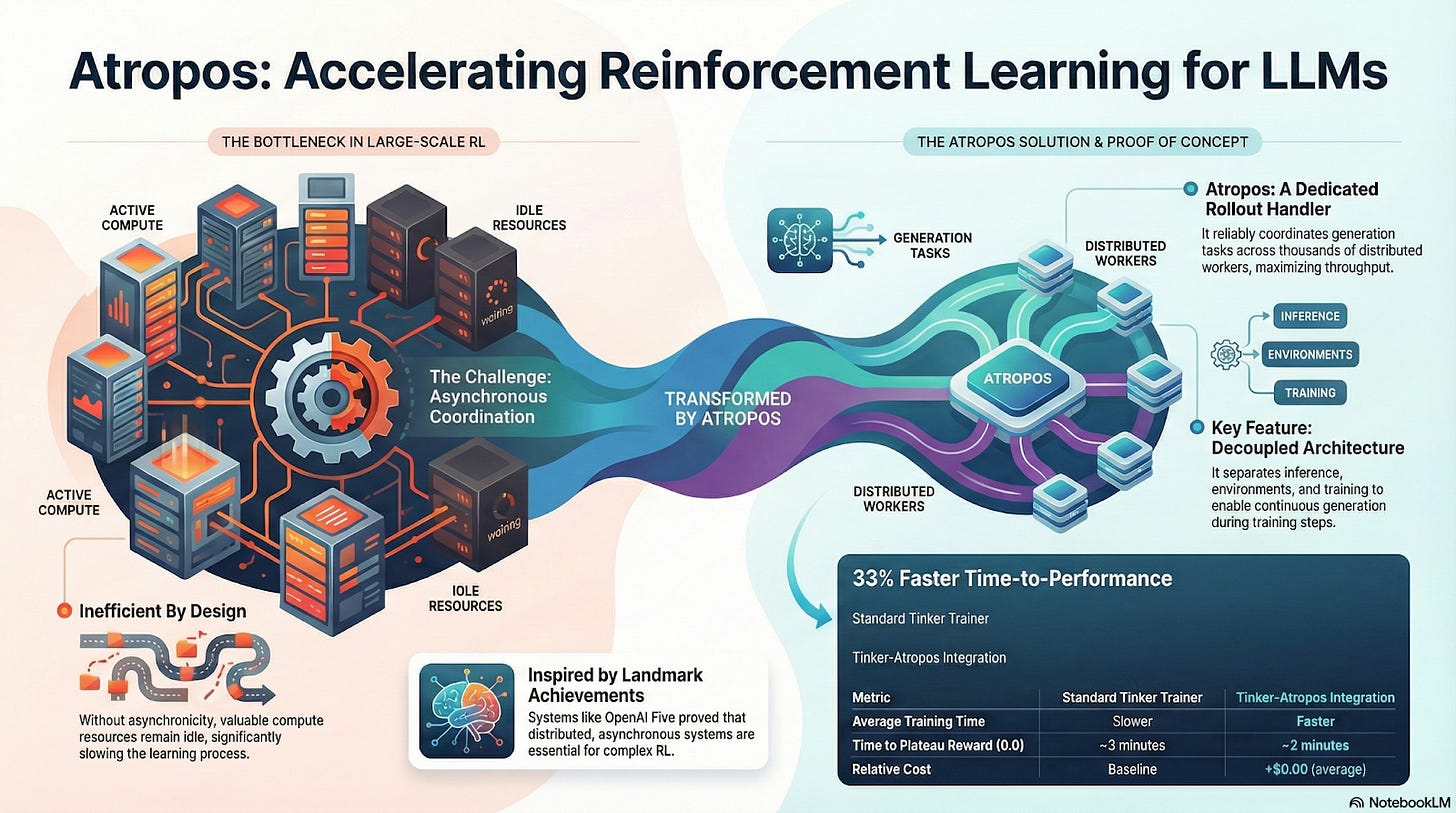

Atropos:可驗證獎勵驅動的強化學習環境

Atropos 是Nous RL 體系的真正樞紐。它將提示、工具呼叫、程式碼執行和多輪互動封裝成標準化RL 環境,可直接驗證輸出是否正確,從而提供確定性獎勵訊號,取代昂貴且不可擴展的人類標註。更重要的是,在去中心化訓練網絡Psyche 中,Atropos 充當“裁判”,用於驗證節點是否真實提升策略,支持可審計的Proof-of-Learning,從根本上解決分佈式RL 中的獎勵可信性問題。

DisTrO 與Psyche:去中心化強化學習的最佳化器層

傳統RLF(RLHF/RLAIF)訓練依賴中心化高頻寬集群,這是開源無法複製的核心壁壘。 DisTrO 透過動量解耦與梯度壓縮,將RL 的通訊成本降低幾個數量級,使訓練能夠在互聯網頻寬上運行;Psyche 則將此訓練機制部署在鏈上網絡,使節點可以在本地完成推理、驗證、獎勵評估與權重更新,形成完整的RL 閉環。

在Nous 的體系中, Atropos 驗證思維鏈;DisTrO 壓縮訓練通訊;Psyche 運行RL 循環;World Sim 提供複雜環境;Forge 收集真實推理;Hermes 將所有學習寫入權重。強化學習不僅是一個訓練階段,而是Nous 架構中連接資料、環境、模型與基礎設施的核心協議,讓Hermes 成為一個能在開源算力網路上持續自我改進的活體系統。

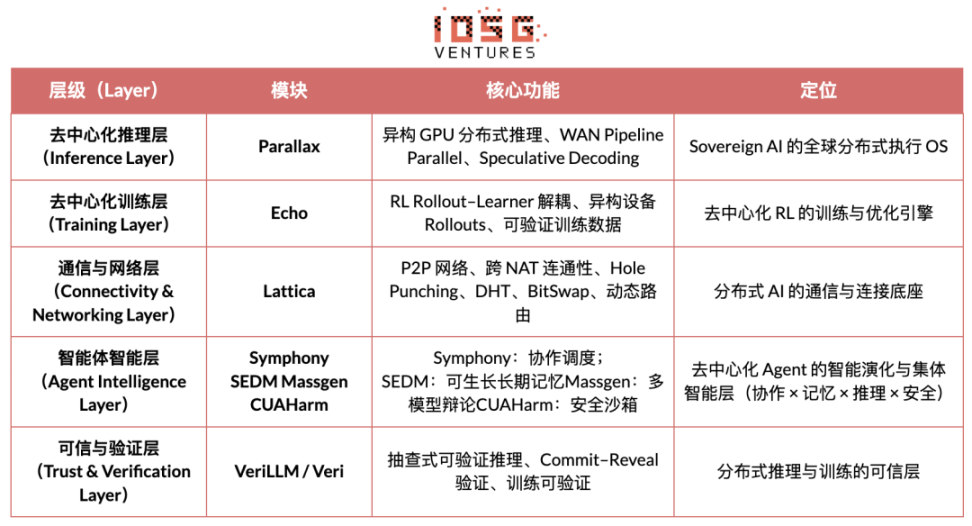

Gradient Network:強化學習架構Echo

Gradient Network 核心願景是透過「開放智慧協定堆疊」(Open Intelligence Stack)重建AI 的運算範式。 Gradient 的技術堆疊由一組可獨立演化、又異質協同的核心協定所組成。其體系從底層通訊到上層智慧協作依序包括:Parallax(分散式推理)、Echo(去中心化RL 訓練)、Lattica(P2P 網路)、SEDM / Massgen / Symphony / CUAHarm(記憶、協作、安全)、VeriLLM(可信任驗證)、Mirage(保真化模擬),共同化模擬構成高進化的基礎設施。

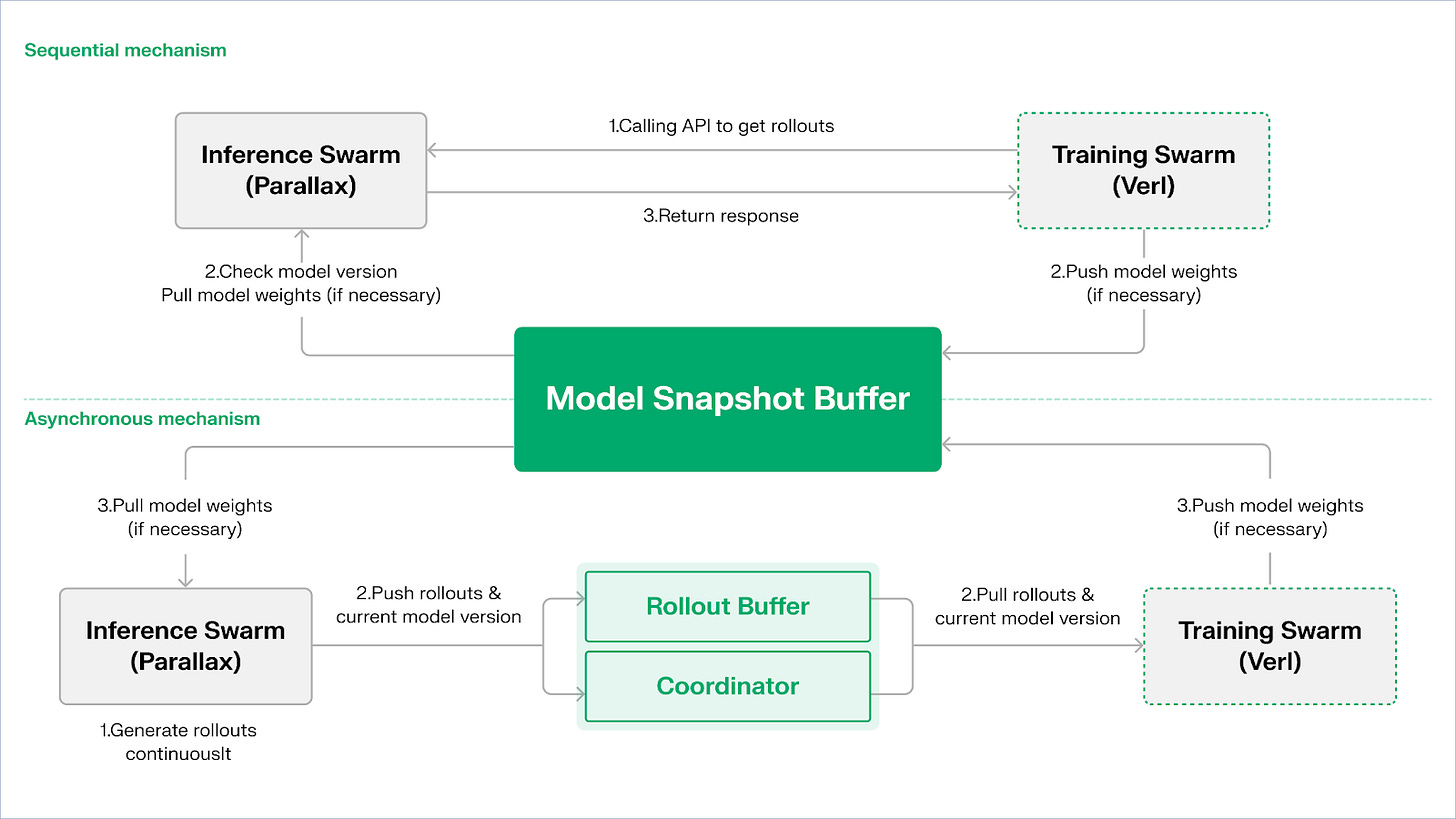

Echo — 強化學習訓練架構

Echo 是Gradient 的強化學習框架,其核心設計理念在於解耦強化學習中的訓練、推理與資料(獎勵)路徑,使Rollout 產生、策略優化與獎勵評估能夠在異質環境中獨立擴展與調度。在由推理側與訓練側節點組成的異質網路中協同運行,以輕量同步機制在廣域異質環境中維持訓練穩定性,有效緩解傳統DeepSpeed RLHF / VERL 中推理與訓練混跑導致的SPMD 失效與GPU 利用率瓶頸。

Echo 採用「推理–訓練雙群架構」來實現算力利用最大化,雙群各自獨立運行,互不阻塞:

最大化採樣吞吐:推理群Inference Swarm 由消費級GPU 與邊緣設備組成,透過Parallax 以pipeline‐parallel 建構高吞吐採樣器,專注於軌跡生成;

最大化梯度算力:訓練群Training Swarm 由可運行於中心化群集或全球多地的消費級GPU 網絡,負責梯度更新、參數同步與LoRA 微調,專注於學習過程。

為維持策略與資料的一致性,Echo 提供順序(Sequential) 與非同步(Asynchronous) 兩類輕量級同步協議,實現策略權重與軌跡的雙向一致性管理:

順序拉取(Pull)模式|精度優先:訓練側在拉取新軌跡前強制推理節點刷新模型版本,從而確保軌跡新鮮度,適合對策略陳舊高度敏感的任務;

非同步推拉(Push–Pull)模式|效率優先:推理側持續產生帶有版本標籤的軌跡,訓練側依自身節奏消費,協調器監控版本偏差並觸發權重刷新,最大化設備利用率。

在底層,Echo 建構於Parallax(低頻寬環境下的異質推理)與輕量化分散式訓練元件(如VERL) 之上,依賴LoRA 降低跨節點同步成本,使強化學習可在全球異質網路上穩定運作。

Grail:Bittensor 生態的強化學習

Bittensor 透過其獨特的Yuma 共識機制,建構了一個巨大的、稀疏的、非平穩的獎勵函數網路。

Bittensor 生態中的Covenant AI 則透過SN3 Templar、SN39 Basilica 與SN81 Grail 建構了從預訓練到RL 後訓練的垂直一體化管線。其中,SN3 Templar 負責基礎模型的預訓練,SN39 Basilica 提供分佈式算力市場,SN81 Grail 則作為面向RL 後訓練的“可驗證推理層”,承載RLHF / RLAIF 的核心流程,完成從基礎模型到對齊策略的閉環優化。

GRAIL 目標是以密碼學方式證明每個強化學習rollout 的真實性與模型身份綁定,確保RLHF 能夠在無需信任的環境中被安全執行。協定透過三層機制建立可信任鏈條:

確定性挑戰產生:利用drand 隨機信標與區塊雜湊產生不可預測但可復現的挑戰任務(如SAT、GSM8K),杜絕預計算作弊;

透過PRF 索引採樣與sketch commitments,使驗證者以極低成本抽檢token-level logprob 與推理鏈,確認rollout 確實由宣告模型產生;

模型身分綁定:將推理過程與模型權重指紋及token 分佈的結構性簽章綁定,確保替換模型或結果重播都會立即被辨識。由此,為RL 中推理軌跡(rollout)提供了真實性根基。

在此機制上,Grail 子網路實現了GRPO 風格的可驗證後訓練流程:礦工為同一題目產生多條推理路徑,驗證者依據正確性、推理鏈品質與SAT 滿足感評分,並將歸一化結果寫入鏈上,作為TAO 權重。公開實驗顯示,該框架已將Qwen2.5-1.5B 的MATH 準確率從12.7% 提升至47.6%,證明其既能防作弊,也能顯著強化模型能力。在Covenant AI 的訓練堆疊中,Grail 是去中心化RLVR/RLAIF 的信任與執行基石,目前尚未正式主線上線。

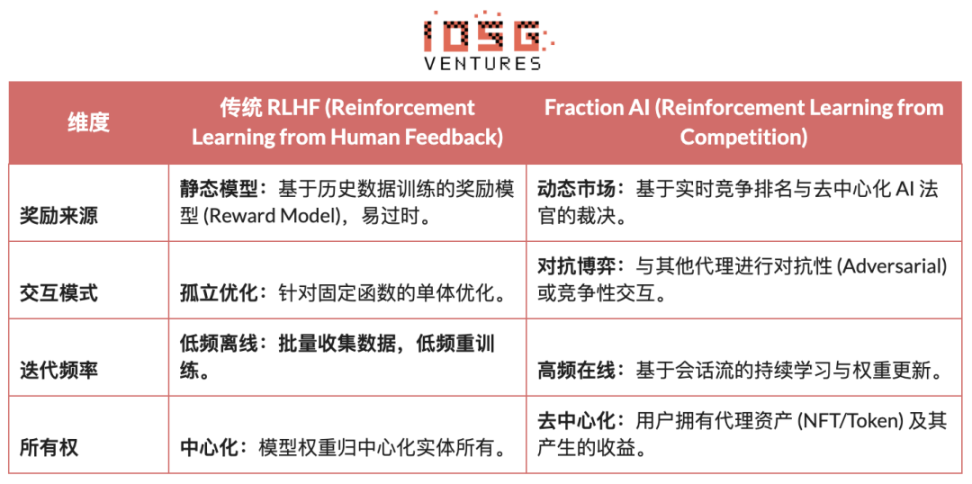

Fraction AI:基於競爭的強化學習RLFC

Fraction AI 的架構明確圍繞著競爭強化學習(Reinforcement Learning from Competition, RLFC) 和遊戲化資料標註構建,將傳統RLHF 的靜態獎勵與人工標註替換為開放、動態的競爭環境。代理人在不同Spaces 中對抗,其相對排名與AI 法官評分共同構成即時獎勵,使對齊過程演變為持續在線的多智能體博弈系統。

傳統RLHF 與Fraction AI 的RLFC 之間的核心差異:

RLFC 的核心價值在於獎勵不再來自單一模型,而來自不斷演化的對手與評估者,避免獎勵模型被利用,並透過策略多樣性防止生態陷入局部最優。 Spaces 的結構決定博弈性質(零和或正和),在對抗與協作中推動複雜行為湧現。

在系統架構上,Fraction AI 將訓練過程拆解為四個關鍵組件:

Agents:基於開源LLM 的輕量策略單元,透過QLoRA 以差分權重擴展,低成本更新;

Spaces:隔離的任務域環境,代理付費進入並以勝負獲得獎勵;

AI Judges:以RLAIF 建構的即時獎勵層,提供可擴展、去中心化的評估;

Proof-of-Learning:將策略更新綁定到具體競爭結果,確保訓練過程可驗證、防作弊。

Fraction AI 的本質是建構了一個人機協同的演化引擎。使用者作為策略層的「元優化者」 (Meta-optimizer),透過提示工程(Prompt Engineering)和超參配置引導探索方向;而代理在微觀的競爭中自動產生海量的高品質偏好數據對(Preference Pairs)。這種模式讓資料標註透過「去信任化微調」 (Trustless Fine-tuning) 實現了商業閉環。

強化學習Web3 專案架構比較

五. 總結與展望:強化學習× Web3 的路徑與機會

基於上述前沿專案的解構分析,我們觀察到:儘管各團隊的切入點(演算法、工程或市場)各異,但當強化學習(RL)與Web3 結合時,其底層架構邏輯皆收斂為一個高度一致的「解耦- 驗證- 激勵」範式。這不僅是技術上的巧合,更是去中心化網路適配強化學習獨特屬性的必然結果。

強化學習通用架構特徵:解決核心的物理限制與信任問題

推訓物理分離(Decoupling of Rollouts & Learning) —— 預設計算拓樸

通訊稀疏、可並行的Rollout 外包給全球消費級GPU,高頻寬的參數更新集中於少量訓練節點,從Prime Intellect 的非同步Actor–Learner 到Gradient Echo 的雙群架構皆如此。

驗證驅動的信任層(Verification-Driven Trust) —— 基礎設施化

在無需許可的網路中,計算真實性必須透過數學與機制設計強制保障,代表實現包含Gensyn 的PoL、Prime Intellect 的TOPLOC 與Grail 的密碼學驗證。

代幣化的激勵閉環(Tokenized Incentive Loop) —— 市場自我調節

算力供給、資料產生、驗證排序與獎勵分配形成閉環,透過獎勵驅動參與、透過Slash 抑製作弊,使網路在開放環境中仍保持穩定與持續演進。

差異化技術路徑:一致架構下的不同「突破點」

儘管架構趨同,但各專案根據自身基因選擇了不同的技術護城河:

演算法突破派(Nous Research):試圖從數學底層解決分散式訓練的根本矛盾(頻寬瓶頸)。其DisTrO 優化器旨在將梯度通訊量壓縮數千倍,目標是讓家庭寬頻也能跑得動大模型訓練,這是對物理限制的「降維打擊」。

系統工程派(Prime Intellect, Gensyn, Gradient):著重於建構下一代的「AI 運行時系統」。 Prime Intellect 的ShardCast 和Gradient 的Parallax 都是為了在現有的網路條件下,透過極致的工程手段壓榨出最高的異質集群效率。

市場博弈派(Bittensor, Fraction AI):專注獎勵函數(Reward Function)的設計。透過設計精妙的評分機制,引導礦工自發性尋找最優策略,來加速智慧湧現。

優勢、挑戰與終局展望

在強化學習與Web3 結合的典範下,系統層級優勢首先體現在成本結構與治理結構的重寫。

成本重塑:RL 後訓練(Post-training)對採樣(Rollout)的需求是無限的,Web3 能以極低成本調動全球長尾算力,這是中心化雲廠商難以比擬的成本優勢。

主權對齊(Sovereign Alignment):打破大廠對AI 價值觀(Alignment)的壟斷,社區可以透過Token 投票決定模型「什麼是好的回答」,實現AI 治理的民主化。

同時,這套體係也面臨兩大結構性約束。

頻寬牆(Bandwidth Wall):儘管有DisTrO 等創新,物理延遲仍限制了超大參數模型(70B+)的全量訓練,目前Web3 AI 更局限於微調和推理。

古德哈特定律(Reward Hacking):在高度激勵的網絡中,礦工極易「過度擬合」獎勵規則(刷分)而非提升真實智能。設計防作弊的穩健獎勵函數是永恆的博弈。

惡意拜占庭式節點攻擊(BYZANTINE worker):透過對訓練訊號的主動操縱與投毒破壞模型收斂。核心不在於持續設計防作弊的獎勵函數,而是建構具備對抗性穩健性的機制。

強化學習與Web3 的結合,本質是在重寫「智能是如何被生產、對齊並分配價值」的機制。其演進路徑可歸納為三條互補方向:

去中心化推訓網絡:從算力礦機到策略網絡,將並行且可驗證的Rollout 外包給全球長尾GPU,短期聚焦可驗證推理市場,中期演化為按任務聚類的強化學習子網;

偏好與獎勵的資產化:從標註勞工到數據股權。 實現偏好與獎勵的資產化,將高品質回饋與Reward Model 變成可治理、可分配的數據資產,從「標註勞工」升級為「數據股權”

垂直領域的「小而美」進化:在結果可驗證、收益可量化的垂直場景中孕育小而強的專用RL Agents,如DeFi 策略執行、代碼生成,使策略改進與價值捕獲直接綁定並有望跑贏通用閉源模型。

整體來看,強化學習× Web3 的真正機會不在於複製一個去中心化版OpenAI,而在於重寫「智慧生產關係」:讓訓練執行成為開放算力市場,讓獎勵與偏好成為可治理的鏈上資產,讓智慧帶來的價值不再集中於平台,而在訓練者、對齊者與使用者之間重新分配。

免責聲明:本文在創作過程中藉助了ChatGPT-5 與Gemini 3 的AI 工具輔助完成,作者已盡力校對並確保資訊真實與準確,但仍難免存在疏漏,敬請諒解。需特別提示的是,加密資產市場普遍存在著專案基本面與二級市場價格表現背離的情況。本文內容僅用於資訊整合與學術/ 研究交流,不構成任何投資建議,亦不應視為任何代幣的買賣推薦。