近期,AI领域掀起了一股投资收购热潮。全球知名企业Salesforce向Anthropic注资4.5亿美元,而Runway则成功筹集到了1.41亿美元的资金。此外,雪花公司也宣布完成了对Neeva的收购,而中国国内巨头美团则以20.65亿收购了AI公司光年之外。

然而,最引人瞩目的交易无疑是初创公司MosaicML的收购案。据了解,MosaicML以约13亿美元的价格被大数据巨头Databricks收购,其估值在本次交易中翻了六倍,成为了今年上半年最大的收购案。仅成立2年时间,拥有60多名员工,是什么撑起了MosaicML的高估值?

Databricks收购MosaicML,加速生成式AI技术民主化

Databricks近期正式宣布,以约13亿美元(约93亿元人民币)收购生成式人工智能初创公司MosaicML,以提供为企业构建类ChatGPT工具的服务。

该收购之后,MosaicML 将成为 Databricks Lakehouse 平台的一部分,MosaicML 的整个团队和技术都将纳入Databricks旗下,为企业提供统一的平台来管理数据资产,并且能够使用自己的专有数据来构建、拥有和保护自己的生成式 AI 模型。

MosaicML是一家非常年轻的生成式AI公司,它于2021年成立于旧金山,目前只公开披露过一轮融资,员工仅62人。在上一轮的融资中,其估值为2.2亿美元,也就是说,此次收购MosaicML的估值直接跃升了6倍。此笔交易是截至目前今年生成式AI领域内所公布的最大一笔收购案。就在不久前,云计算巨头Snowflake刚刚宣布收购了另一家生成式AI公司Neeva。在经历了几个月的投资热之后,大型企业对生成式AI初创公司的大规模并购潮似乎正在开启。

Databricks起源于UC伯克利,曾参与Apache Spark项目开发。作为数据存储和分析巨头,截至2022年估值310亿美元,帮助AT&T、壳牌、Walgreens等大型公司处理数据。前段时间,刚开源了自己大模型Dolly,旨在以更少参数实现与ChatGPT类似的效果。而在云计算更加普及后,Spark提出的“湖仓一体”理念,深深影响了一批大数据初创企业。自2013年成立后,Databricks火速成长为全球最火的Data Infra公司。去年,Databricks公布的年收入超过10亿美元,而在2021年8月完成最新一轮融资后,其最新估值达到380亿美金。

MosaicML MPT系列模型的优势

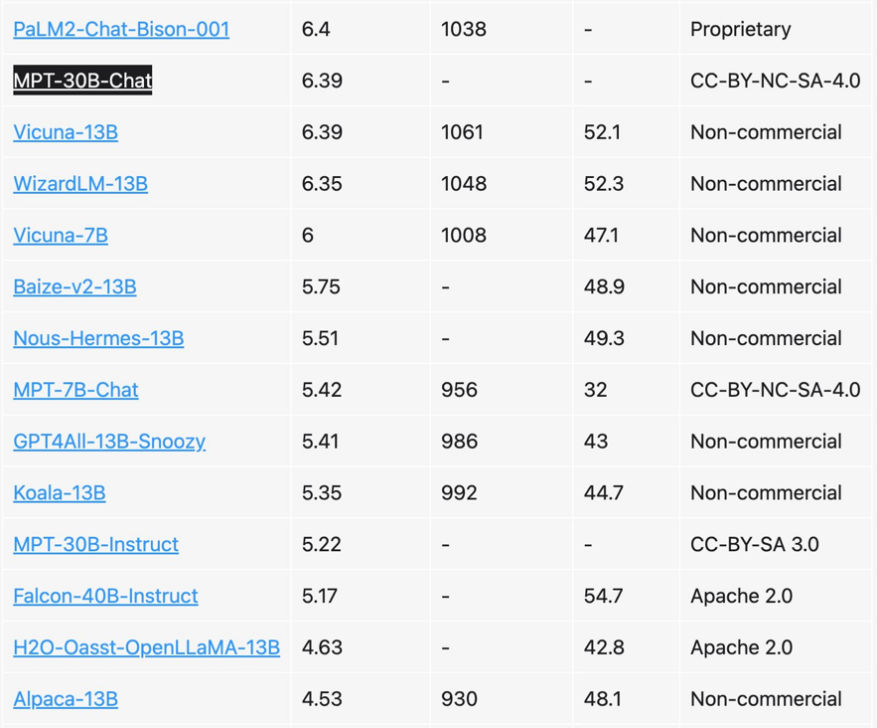

MosaicML的MPT系列模型是从HuggingFace PretrainedModel基类中子类化的,与HuggingFace生态系统完全兼容。MPT-7B模型是MosaicML最受欢迎的模型之一,拥有数十亿个参数,可以处理超过2,000种自然语言处理任务。其中,MPT-7B的优化层包括FlashAttention和低精度层范数等,可以让该模型比传统训练方法快2-7倍,资源的近线性可伸缩性确保了具有数十亿参数的模型可以在几小时内训练,而不是过去的几天。MosaicML还发布了新的可商用的开源大语言模型MPT-30B,拥有300亿参数,并且性能优于GPT-3。

数据来源:MT-Bench对MosaicML主流模型进行的评估

MPT系列模型的优势在于它们的高效性和低成本。使用大量数据进行“训练”的人工智能模型的复杂度急剧上升,训练一个模型现在至少要花费数百万美元,除了大公司之外,其他中小型企业普遍都无法承受。而MosaicML的MPT系列模型可以让企业以更低的成本和更高的效率训练自己的语言模型,从而可以更轻松地应用生成式AI技术,实现更好的业务表现。大多数开源语言模型只能处理最多具有几千个tokens的序列(参见图 1)。但是,借助 MosaicML 平台和 8xA100-40GB 的单个节点,用户可以轻松微调 MPT-7B 以处理高达 65k 的上下文长度。处理这种极端上下文长度适应的能力来自ALiBi,这是MPT-7B中的关键架构选择之一。

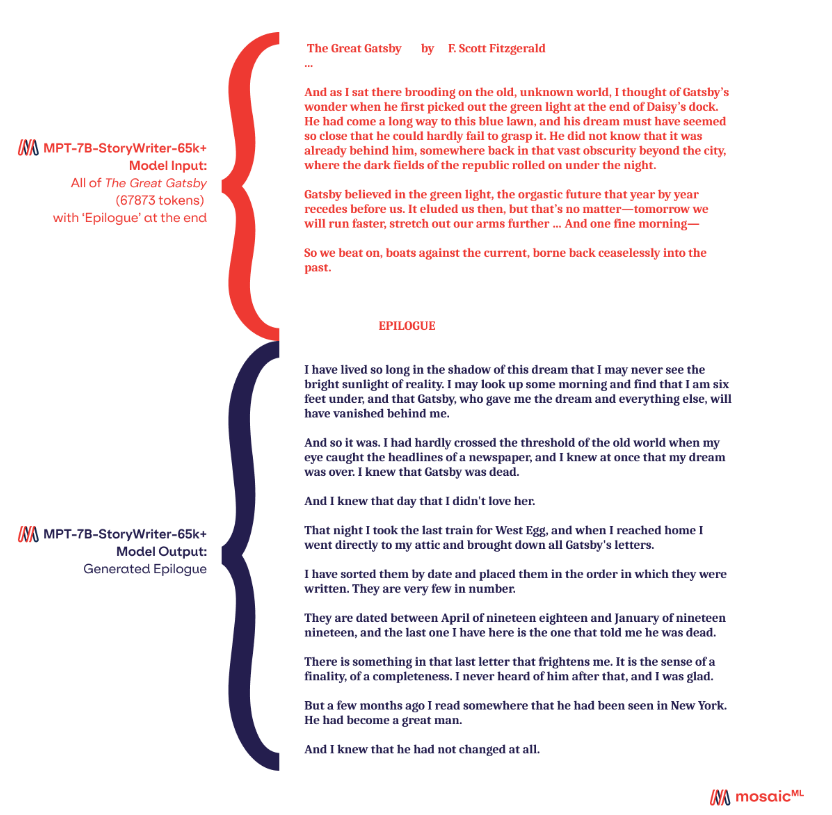

例如,《了不起的盖茨比》的全文不到68k个Token。在一个测试中,模型StoryWriter阅读了《了不起的盖茨比》并生成了一个尾声。模型生成的尾声之一如图 2 所示。StoryWriter在大约20秒内(每分钟约15万字)读完了《了不起的盖茨比》。由于序列长度较长,其“打字”速度比其他MPT-7B型号慢,每分钟约105个单词。尽管 StoryWriter 的上下文长度为 65k 进行了微调,但 ALiBi 使模型能够推断出比训练更长的输入:在《了不起的盖茨比》的情况下为 68k 个Token,在测试中高达 84k 个标记。

图2:MPT-7B-StoryWriter-65k+ 为《了不起的盖茨比》写了尾声。尾声的结果是提供《了不起的盖茨比》的全文(大约 68k 个Token)作为模型的输入,后跟“尾声”一词,并允许模型继续生成。

生成式AI技术的普及

生成式AI技术是人工智能的一种分支,它利用大量的数据和深度学习算法,能够自动生成原始文本、图像和计算机代码等内容。这种技术的出现,让人们可以更加便捷地处理数据、分析数据,更好地服务于人类的需求。随着大数据和人工智能技术的快速发展,生成式AI技术已经被广泛应用于自然语言处理、图像识别和虚拟现实等领域。例如,在自然语言处理领域中,GPT-4已经成为了最受欢迎的生成式AI模型之一,可以用于生成文章、翻译语言和回答问题等任务。在图像识别领域,StyleGAN2能够生成高质量的图像,可以用于游戏开发、影视制作和虚拟现实等领域。

MosaicML的CEO Naveen Rao此前曾表示,自 2018 年以来,使用大量数据进行“训练”的人工智能模型的复杂度急剧上升,训练一个模型现在至少要花费数百万美元,除了大公司之外,其他中小型企业普遍都无法承受。而此次收购之后,Databricks的Lakehouse 平台和 MosaicML 技术的联合产品将能够让企业可以使用自己的专有数据来简单、快速、低成本进行生成式AI模型的训练和构建,在让用户拥有数据的控制权和所有权的情况下,可以进行自定义 AI 模型开发。根据Databricks的相关说法,在 Databricks 和 MosaicML的平台和技术支持下,企业训练和使用 LLMs 的成本将显著降低,预计可以降至数千美元左右。这为生成式AI的普及提供了便利。

Databricks收购MosaicML的意义

Databricks收购MosaicML的主要目的是加速生成式AI技术的发展和民主化。通过将两家公司的技术和资源整合起来,Databricks可以更好地满足客户的需求,提供更高效、更便捷的解决方案。具体而言,该收购将带来以下几个方面的改变:

1. 更高效的大语言模型

Databricks收购MosaicML后,可以将MPT系列模型集成到其Lakehouse平台中,为客户提供更高效、更低成本的大语言模型。这将有助于企业更好地处理自然语言处理任务,提高业务效率和准确性。

2.更快的模型训练速度

MosaicML的MPT系列模型具有快速训练的特点,这将有助于Databricks提供更快速的模型训练服务。这对于需要快速响应市场需求的企业来说尤为重要,可以帮助他们更好地满足客户的需求。

3. 更高的民主化程度

Databricks收购MosaicML也意味着生成式AI技术的民主化程度将会进一步提高。MosaicML的MPT系列模型可以让中小型企业更轻松地训练自己的语言模型,从而可以更好地应用生成式AI技术,实现更好的业务表现。这将有助于推动生成式AI技术的发展和应用,促进人工智能技术的普及和发展。

总结

生成式人工智能应用程序旨在根据用户的自然语言提示生成原始文本、图像和计算机代码。自去年11月人工智能初创公司OpenAI推出在线生成AI聊天机器人ChatGPT以来,人们对这项技术的兴趣激增。“每个组织都应该能够从人工智能革命中受益,并对其数据的使用方式有更多的控制。Databricks 和 MosaicML 有一个难以置信的机会来实现人工智能的民主化,并使 Lakehouse 成为构建生成式人工智能的最佳场所。”Databricks 联合创始人兼首席执行官 Ali Ghodsi表示。

Databricks收购MosaicML的意义不仅在于加速生成式AI技术的发展和民主化,更在于将两家公司的技术和资源整合起来,为客户提供更高效、更便捷的解决方案。随着人工智能技术的快速发展和应用,生成式AI技术将扮演着越来越重要的角色,Databricks收购MosaicML的举动也体现了各企业对于这个方向的重视和投资。像Anthropic和OpenAI这样的公司将现成的语言模型授权给企业,然后企业在其上构建生成AI应用程序。在对这些模型的强劲商业需求的推动下,为像MosaicML这样的初创公司创造了机会。从Snowflake和Databricks接连的收购步伐中我们可以看到,大型科技公司对于生成式AI技术正在从自主研发、战略投资逐步迈向兼并收购阶段。

参考来源:

https://www.databricks.com/company/newsroom/press-releases/databricks-signs-definitive-agreement-acquire-mosaicml-leading-generative-ai-platform

https://mattturck.com/mosaic/

https://twitter.com/lmsysorg/status/1672077353533730817/photo/1

https://www.mosaicml.com/blog/mpt-7b#appendix-eval

https://www.mosaicml.com/blog/mpt-30b