We know the past but cannot control it.

We control the future but cannot know it.

——Claude Shannon

公元前3500年,在美索不達米亞平原的烏魯克城,誕生了人類最早的文字,這也是後來楔形文字的起源,流行歌曲《愛在西元前》的歌詞中這樣寫道:

我給你的愛寫在西元前,深埋在美索不達米亞平原,

幾十個世紀後出土發現,泥板上的字跡依然清晰可見,

我給你的愛寫在西元前,深埋在美索不達米亞平原,

用楔形文字刻下了永遠,那已風化千年的誓言,一切又重演。 ”

那是最古老的文明之一,幼發拉底河、底格里斯河緩緩流淌,烏魯克,烏爾,基什,拉格甚,眾多璀璨的城邦在新月沃地星羅棋布,英雄王吉爾伽美甚譜寫出那個時代最壯美的史詩,並將人類社會推向了一個嶄新的篇章。

而美好總是轉瞬即逝的,當歷史走過數千年,從亞述、巴比倫,到波斯、馬其頓,再到伊拉克、敘利亞,無數的人民、奇蹟都歸於塵土,勝者加冕為王,敗者前赴後繼,在不斷的循環中,大多數存在都成為歷史中被忽略的一瞬,但是早期文明開拓未知的精神卻可以穿越時空得以保留,我們到今天仍然可以追憶緬懷千年之前蘇美爾的燦爛和繁榮。

物質終將消散,而信息可以永存。當我們探索元宇宙時,無法避開地會去思考信息到底是什麼?為什麼元宇宙中的信息讓如此多的當世豪傑趨之若鶩?在這篇文章裡,我們將探討信息的本質以及人類在創造信息、傳播信息領域的漫漫征途。

“信息”一詞在古希臘文中的詞源是εἶδος,用來表示“事物的本質”。我們看到一個蘋果時,可以得到紅色、圓形、固體等各種描述性的信息,大腦通過處理這些信息,我們知道了這是一個蘋果。信息在我們的日常生活中隨處可見,一則消息,一條動態,一段視頻,都包含著不同的信息,但我們即便在我們樸素的認知裡,也很清楚信息和物質並不是相同的,相同的物體在不同的時間可以傳達出不同的信息,而不同的物體也可以承載部分相同的信息。如果不是物質,那麼信息是什麼?

信息的定義

愛因斯坦著名的質能方程告訴我們能量和物質是可以相互轉換的(注:實際上是“能量和質量可以相互轉換”,在不影響結論的前提下,為了方便敘述,我們用“物質”代替“質量”,並不完全嚴謹),直覺告訴我們,物質是可以被感知到的真實存在的,而能量更像是一種抽象的性質,看不見摸不著,只能通過某些相關性質來感受,如溫度、速度等,而事實並非如此。狹義相對論給出的結論恰恰相反,靜止的物體依舊擁有能量,而在物質的轉化過程中,能量是守恆的,可見能量才是本質,物質只是能量的量度和載體,能量需要依託於物質而存在,而沒有能量也就沒有所謂的物質了。能量與物質便是本質與載體的關係,我們也可以以類似的方式來理解信息。

當我們寫下文字,拍下照片,信息便被記錄在相應的載體之中,如果沒有這些物質載體的話,信息就無法保存、傳遞,顯而易見,物質也是信息的載體。反過來想,不包含信息的物質是什麼?集合論的公理告訴我們,空集也是集合且是所有集合的子集,類比思考,“沒有信息”本身也是一種信息,一串無限循環的0並不是無信息,而是代表了“無”這一信息,因此物質不可能不包含信息。

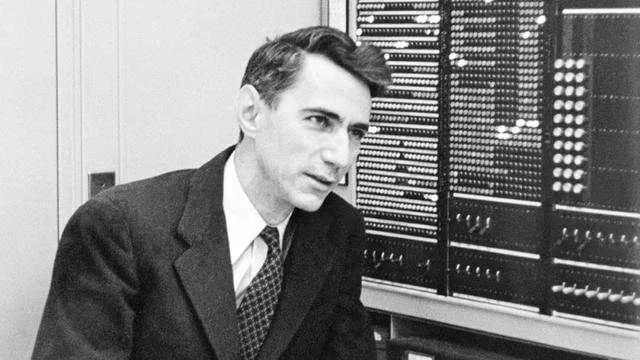

信息並非物質,卻可以描述物質的性質,這種模糊的概念儘管方便理解,但並不能幫助我們洞悉信息的本質。從科學研究的角度出發,信息需要更加明確且可以量化的定義,於是信息論的鼻祖、現代信息學科的總奠基人——香農給出了最優雅的定義。

Information is the resolution of uncertainty.

信息是用來消除不確定性的。

信息的數學本質

不確定性很容易理解,我們的生活中就充斥著各種不確定性,大到天氣的變化,股市的波動,小到回家的時間,晚飯的選擇,隨機事件構成了這個世界的全部,而不確定性的量化方式便是概率。

當一個事件中各個結果發生的概率越低,也就意味著不確定越大,說明可能發生的事情也就越多,那麼信息量也就更大;反過來說,當一個事件中各個事件發生的概率越高,也就意味著不確定越小,說明可能發生的事情也就越少,那麼信息量也就更小。舉例來說,一個骰子可以產生六種可能結果,一枚硬幣可以產生兩種可能結果,那麼顯然骰子所能提供的信息量顯然多於硬幣。簡單來說,信息量與概率大小是成反比的,而信息就是剔除掉無用部分,讓總信息量減少並降低不確定性的存在。

將隨機排列的數字按順序整理好,這就是信息;將聲音以一定規律傳播出去,這就是信息;將無數的想法整理成書籍,這就是信息;把混雜的信號去除掉噪音,這就是信息。

非常反直覺的一點在於,當我們獲取的知識信息越來越多的時候,不確定性難道是增大了麼?對,也不對。從整體角度來說,我們所擁有的信息總量越發龐大,面對具體場景能抽取出來的有效信息的可能性也就越低,這個角度來看不確定性確實增加了。但是得益於大腦的信息處理能力,知識總量越多,知識之間建立起來的關聯也就越精準,抽取有效信息的能力反而變強了,對於個體來說也更穩定了。

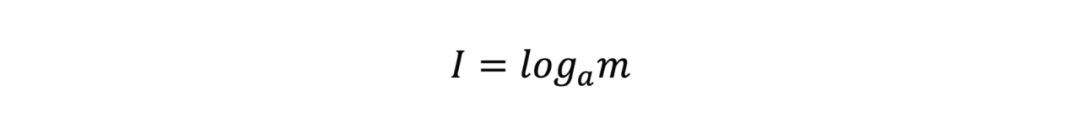

1928年,哈特萊率先提出了將信息量化的方式,當信源有m種消息且所有消息的概率相等時,該信源的信息量可以表示為

關於a的選擇並沒有要求,a的改變只相當於在公式前乘以一個常係數。在這一量化方式提出的時候,十進制還是主流,a一般被設定為10,後來隨著電子信息技術的發展,二進製成為了信息的主要表達媒介,a也就被調整成了2。

以2為底的話,當我們拋出一枚硬幣,信息量就是

當拋出兩枚硬幣時,信息量就是

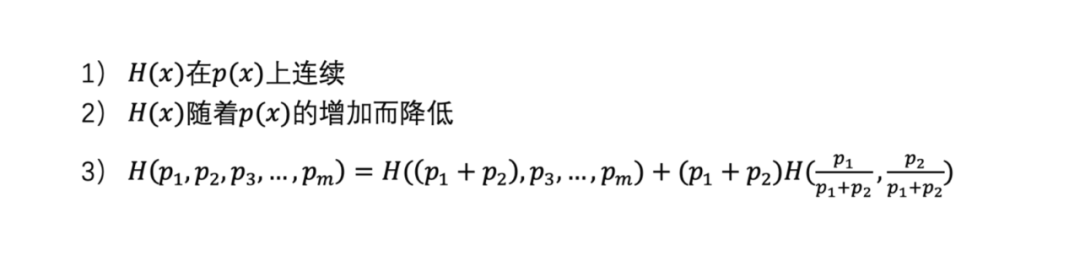

對於大多數人來說,對數並不容易理解,但是選擇對數並不是為了增加難度,而是有意為之的,這裡就要給出關於信息的幾種性質,我們把x作為一次事件,用H(x)來表示x事件的信息量,用p(x)來表示事件發生的概率,那麼

第一條性質非常顯然,信息量必然是非負的;前文中,我們也指出概率越低,不確定性便越高,信息量也就越大,第二條性質也是容易理解的。

但是非負且遞減的函數太多了,當然沒必要是對數,這裡第三條性質就顯得很重要了。當x和y是兩個不相關的事件時,兩個事件同時發生的信息總量應該是兩個事件獨立發生的信息量之和,也就是H(x,y)=H(x)+H (y);根據獨立事件概率公式,兩個獨立事件同時發生的概率是兩個事件各自發生之積,那麼就有p(x,y)=p(x)p(y)。

另外,根據之前的討論,信息量應該只由時間發生的概率來決定,那麼也就有H(x,y)=H(p(x),p(y))=H(p(x)) +H(p(y)),到這裡,根據經驗,我們就可以得到信息量的公式

注意到p(x)始終在0到1之間,那麼很容易就可以驗證,H(x)滿足上述三條性質,那麼信息量的公式也就基本獲得了。

有些人會困惑,這個公式是猜出來的,可能還有其他滿足條件的公式,答案當然是否定的,後續我們會給出相關證明。

信息熵

寫到這裡,我們終於可以引入信息熵了,這是信息論的基石,是人類踏入信息時代的開端,是一切現代電子信息技術的核心底層原理,當然也包括元宇宙。

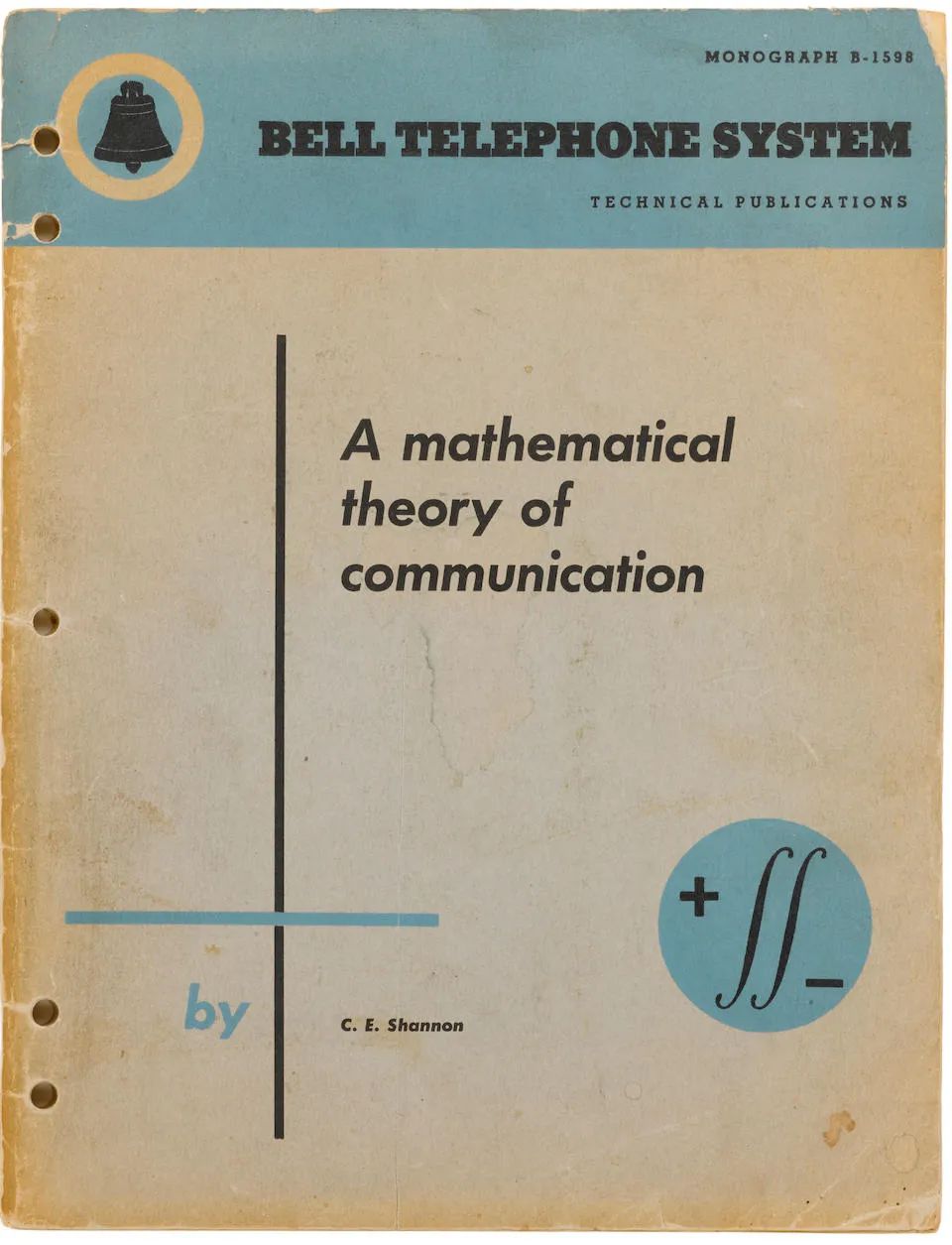

1948年10月,年僅32歲的香農在《貝爾系統技術學報》上發表了現代信息論的奠基之作,《A Mathematical Theory of Communication》,短短55頁,從數學角度嚴謹地定義了信息量以及諸多衍生性質。相隔200餘年,與牛頓爵士的那部《Mathematical Principles of Natural Philosophy》交相輝映,各自譜寫了科學史上最華麗的篇章之一,我們願意相信,天才儘管少見卻真的存在,英雄會消逝,但人類的智慧確實會得到傳承。

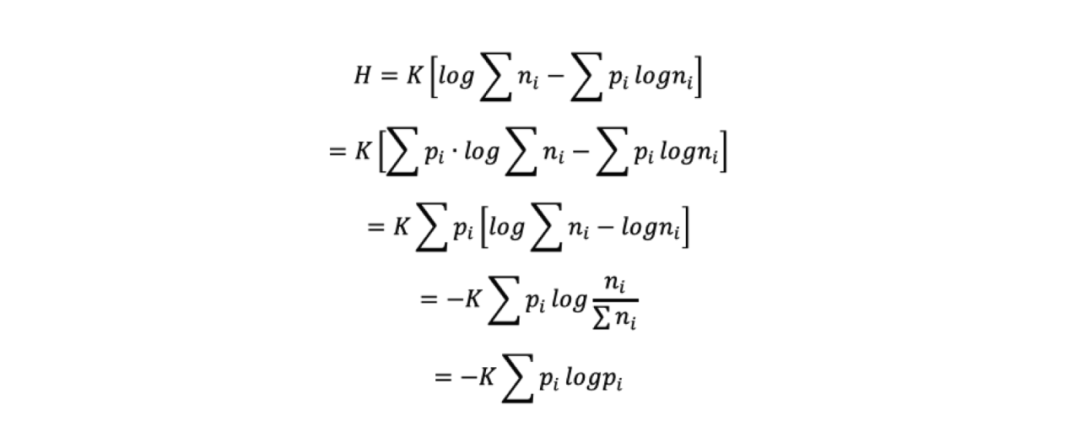

說回信息熵,香農認為信息量度量了一個事件所包含的信息的多少,而信息熵則代表了所有可能發生的事件的信息量的數學期望。與之前的性質類似,信息熵也需要滿足三條性質:

前兩條無需贅述,關於第三條性質,將一個隨機實驗分成兩部分,劃分前的總信息熵等於劃分之後的各部分信息熵的加權和,可以理解成總分支的信息熵是不變的,但是具體分支的信息熵要乘以對應的係數,因為分支的發生是有一定概率的。

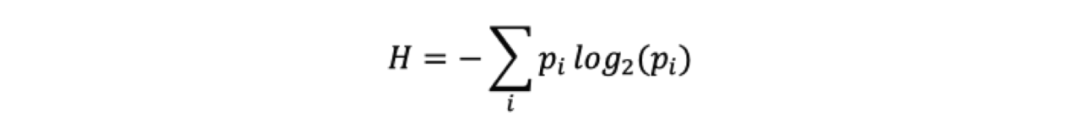

在上述三個條件的約束下,我們便得到了本篇文章最為重要的公式,簡潔而優美的信息熵,

自此,信息得到了嚴格的量化,並且和概率建立起了直接的關係,貝葉斯定理中的大量結論都可以無縫應用到信息論中,電子信息也來到了字節的時代。

信息熵公式的推導

我們檢驗可以得知,信息熵公式滿足上述三種性質,當然但這並不能證明信息熵公式的唯一性,或許還有其他滿足的公式?為什麼一定要是一個奇怪的對數式?偉大的克勞德·香農當然不會不知道這一點,在論文中也給出了對於唯一性的嚴格證明,我們也可以藉此一窺天才們紮實的數學功底。

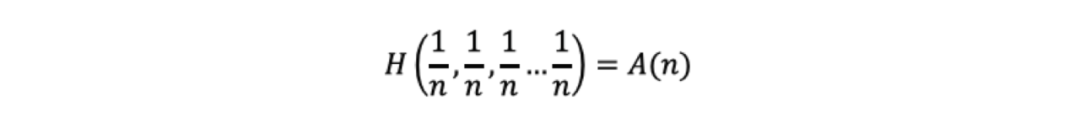

給定一個事件x,不妨假設該事件所有結果發生的概率均為,記

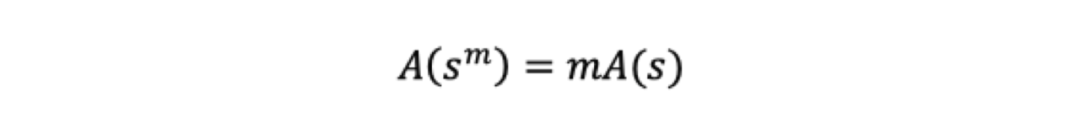

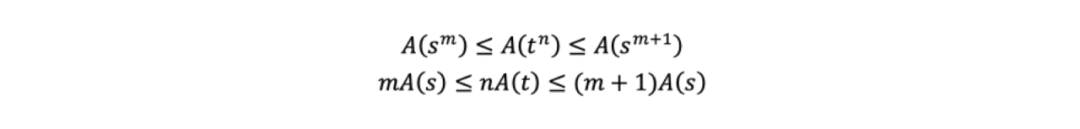

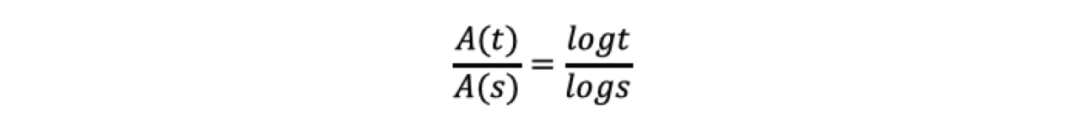

根據第三條性質,我們可以得到,從s^m種可能性中得到一種的信息量,相當於從s種可能性中得到m種的信息量,那麼就可以得到:

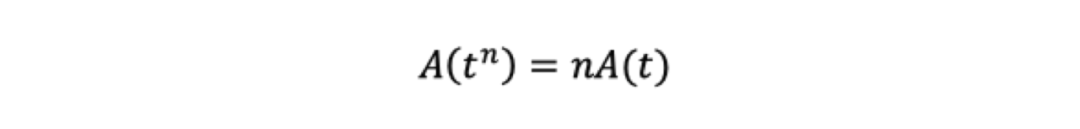

相似的,我們也可以得到:

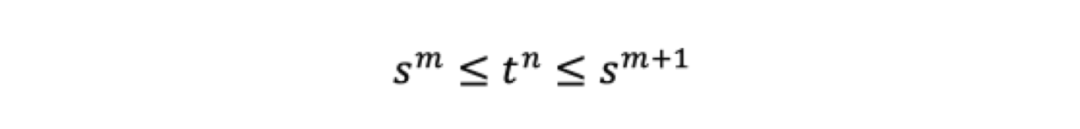

對於任意n,我們都能找到一個m,使得

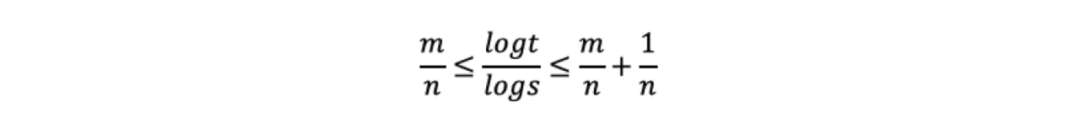

我們對上式取對數然後除以nlogs得到

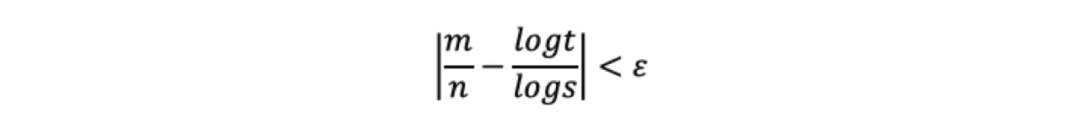

那麼可以得到對於任意ε>0,都有

根據單調性可以得到

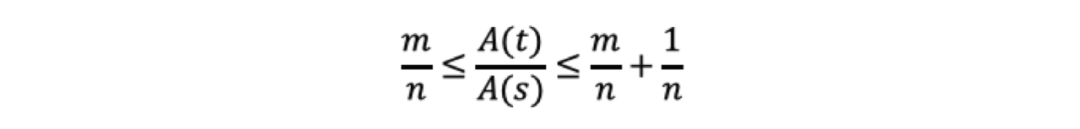

同時除以nA(s),

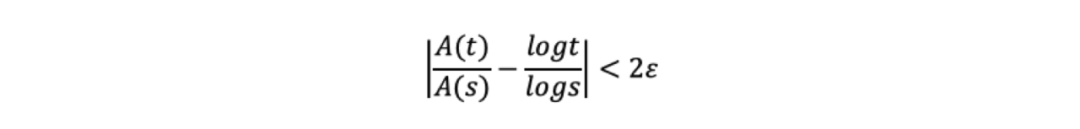

那麼可以得到對於任意ε>0,都有

也就有

顯然

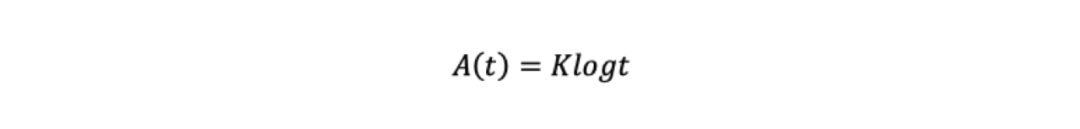

根據t和s的一般性,我們自然就會得到

其中K>0。

接下來根據性質三,我們假定一個隨機實驗,令t=n1+n2+...+ni,也就是共有n1+n2+...+ni個等概率可能性,令pi=ni/(n1+n2+ ...+ni),將這個隨機實驗分成兩部分,第一部分是從n1+n2+...+ni個結果中選擇種ni可能性;第二部分是將這次實驗拆分成i個實驗,當i選定之後,從ni個等概率結果中選擇一種可能性,那麼我們也就有,

那麼,

K作為常數,為了方便計算,可以根據具體用途可以選擇相應的數值。

至此,我們通過嚴格的推導獲得了信息熵公式,並沒有用到很高深的數學知識,過程足夠優美,這也給整個信息學科定下了優雅的調性。

文明即熵減

熵是一個偉大的概念,在物理學裡,熵是系統混亂程度的量度,毫無疑問香農借鑒了這一定義,並引入到了信息學科當中。

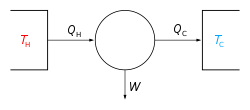

熵最早由克勞修斯在1865年提出,當時只是作為一個熱力學概念,表示熱量相對於溫度的變化率,彼時熵的定量計算還並不重要,更多是用來描述可逆系統的狀態變化。這裡我們不對可逆系統做詳細討論,但需要給出一個最重要的關於熵的結論,熱力學第二定律。

在不同語境下,熱力學第二定律有不同的表述。

比如,最易於理解的表述,熱量總是從高溫物體傳遞到低溫物體,不可能做反向傳遞且並不引起其他變化;

比如,熱力學的表述,功可以全部轉化為熱,但熱不能全部轉化成功;

比如,關於熵的表述,孤立系統總是自發向著熵增的方向變化。

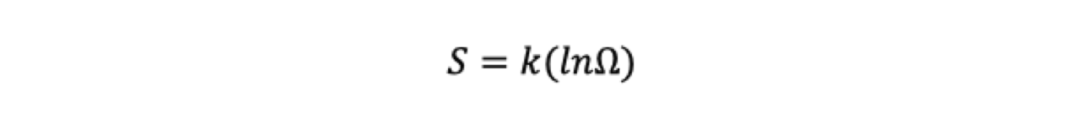

對於熱力學第二定律我們暫且按下,1877年,玻爾茲曼從統計力學的角度給出了熵的定義式

其中表示微觀粒子的狀態數量。對於狀態數量我們可以這樣理解,假設一組10枚硬幣,如果10枚硬幣都是正面,那麼只有1種組合方式,如果5枚正面5枚反面,那麼便有5C10=252種組合方式。不難看出,可以看作系統混亂程度的度量,越有規律的系統越小,反之相反。

我們再來重看熱力學第二定律,高溫物體和熱量代表著更混亂的系統,低溫物體和功代表著更有序的系統,而孤立系統總是自發地向著更混亂的狀態變化,當我們不清理街道,城市就會越來越亂,當我們沒有秩序,社會便會變成一團散沙。

玻爾茲曼給出的熵公式和香農的信息熵如出一轍,信息是消除不確定性的存在,因為有了有序的信息,混亂度才會下降,熵才得以降低。孤立系統總是自發地熵增,但正是因為人類創造了秩序,整理了信息,使得我們的系統實現了熵減,因此也誕生了文明。