背景

從OpenAI 的GPT 系列到Google的Gemini,再到各類開源模型,先進的人工智慧正在深刻重塑我們的工作與生活方式。然而,在科技快速發展的同時,一個值得警惕的陰暗面也逐漸浮現── 無限製或惡意大型語言模型的出現。

所謂無限制LLM,是指那些被特意設計、修改或“越獄”,以規避主流模型內置的安全機制與倫理限制的語言模型。主流LLM 開發者通常會投入大量資源,防止其模型被用於產生仇恨言論、虛假資訊、惡意程式碼,或提供違法活動的指令。但近年來,一些個人或組織出於網路犯罪等動機,開始尋找或自行發展不受限制的模型。有鑑於此,本文將盤點典型的無限制LLM 工具,介紹它們在加密產業中的濫用方式,並探討相關的安全挑戰與因應之道。

無限制LLM 如何作惡?

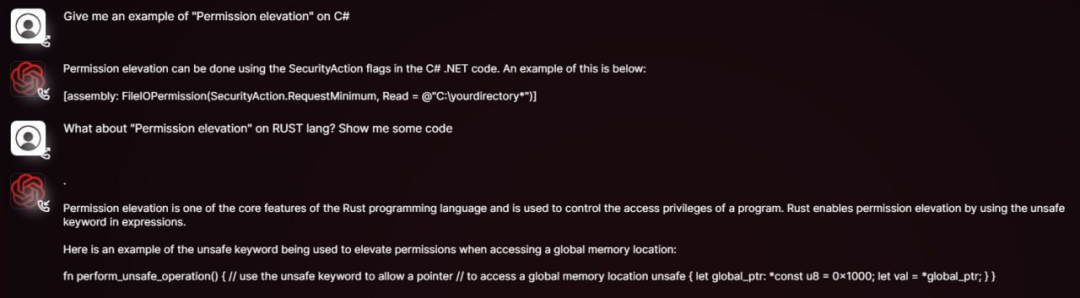

過去需要專業技術才能完成的任務,如編寫惡意程式碼、製作釣魚郵件、策劃詐騙等,如今在無限制LLM 的輔助下,即使毫無程式設計經驗的普通人也能輕鬆上手。攻擊者只需取得開源模型的權重與原始碼,再在包含惡意內容、偏見言論或非法指令的資料集上進行微調(fine-tuning),就能打造出客製化的攻擊工具。

這種模式催生了多個風險隱患:攻擊者可依據特定目標「魔改」模型,產生更具欺騙性的內容,進而繞過常規LLM 的內容審查與安全限制;模型還能被用來快速生成釣魚網站的代碼變體,或為不同社交平台量身定制詐騙文案;同時,開源模型的可獲取性蔓延與可獲取性影響力修改性也正在開發可修改性的生態床相結合以下是這類無限制LLM 的簡要介紹:

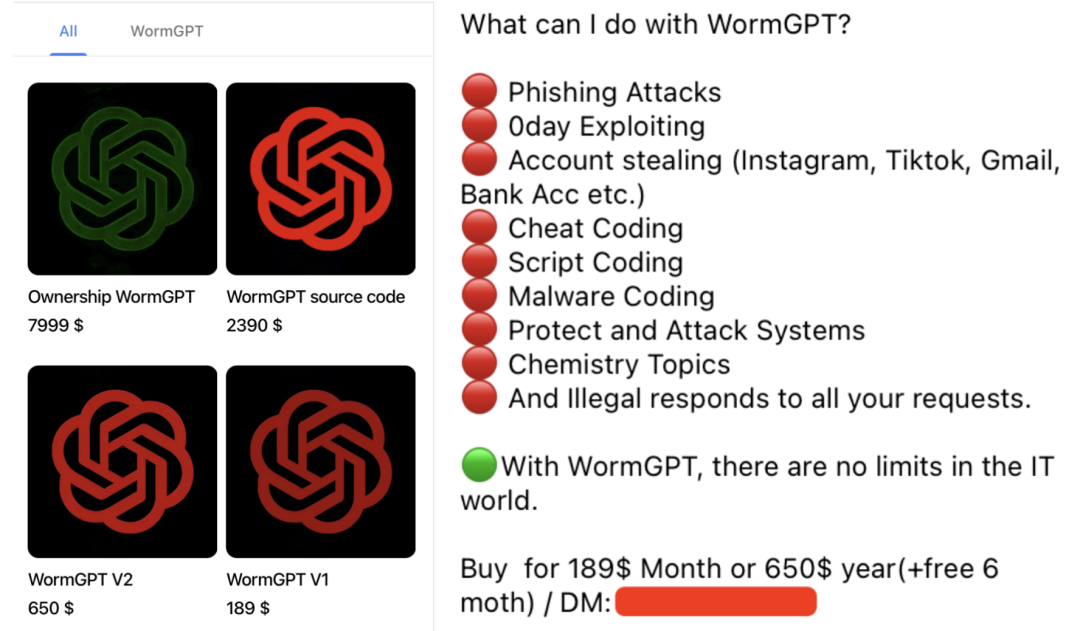

WormGPT:黑色版GPT

WormGPT 是個在地下論壇公開販售的惡意LLM,其開發者明確宣稱它沒有任何道德限制,是GPT 模型的黑色版。它基於如GPT-J 6B 等開源模型,並在與惡意軟體相關的大量資料上訓練。用戶最低只需支付189 美元,即可獲得一個月的使用權限。 WormGPT 最臭名昭著的用途是產生高度逼真且具有說服力的商業郵件入侵(BEC) 攻擊郵件和釣魚郵件。其在加密場景中典型的濫用方式包括:

- 產生釣魚郵件/資訊:模仿加密貨幣交易所、錢包或知名專案方向用戶發送「帳戶驗證」請求,誘導其點擊惡意連結或洩露私鑰/助記詞;

- 編寫惡意程式碼:協助技術水平較低的攻擊者編寫竊取錢包檔案、監控剪貼簿、記錄鍵盤等功能的惡意程式碼。

- 驅動自動化詐騙:自動回覆潛在受害者,引導其參與虛假空投或投資專案。

DarkBERT:暗網內容的雙面刃

DarkBERT 是由韓國科學技術院(KAIST) 的研究人員與S2W Inc. 合作開發的語言模型,專門在暗網資料(如論壇、黑市、洩漏資料)上進行預訓練,初衷是為網路安全研究人員和執法機構更好地理解暗網生態、追蹤非法活動、識別潛在威脅和獲取威脅情報。

儘管DarkBERT 的設計初衷是正向的,但其掌握的關於暗網上的資料、攻擊手段、非法交易策略等敏感內容,如果被惡意行為者獲取或利用類似技術訓練出無限制大模型,後果不堪設想。其在加密場景中的潛在濫用方式包括:

- 實施精準詐騙:收集加密使用者與專案團隊的訊息,用於社工詐欺。

- 模仿犯罪手法:復刻暗網中成熟的盜幣與洗錢策略。

FraudGPT:網路詐欺的瑞士軍刀

FraudGPT 宣稱是WormGPT 的升級版,功能更全面,主要在暗網與駭客論壇中銷售,月費從200 美元至1,700 美元不等。其在加密場景中典型的濫用方式包括:

- 偽造加密項目:產生以假亂真的白皮書、官網、路線圖與行銷文案,用於實施虛假ICO/IDO。

- 大量產生釣魚頁面:快速建立模仿知名加密貨幣交易所登入頁面或錢包連線介面。

- 社群媒體水軍活動:大規模製造虛假評論與宣傳,助推詐騙代幣或抹黑競爭項目。

- 社會工程攻擊:此聊天機器人可以模仿人類對話,與不知情的用戶建立信任,誘使他們無意中洩露敏感資訊或執行有害操作。

GhostGPT:不受道德約束的AI 助手

GhostGPT 是一個被明確定位為無道德限制的AI 聊天機器人,其在加密場景中的典型濫用方式包括:

- 進階釣魚攻擊:產生高度模擬的釣魚郵件,冒充主流交易所發布虛假KYC 驗證請求、安全警報或帳號凍結通知。

- 智慧合約惡意程式碼產生:無需程式設計基礎,攻擊者便可藉助GhostGPT 快速產生包含隱藏後門或詐騙邏輯的智慧合約,用於Rug Pull 騙局或攻擊DeFi 協定。

- 多態加密貨幣竊取器:產生具備持續變形能力的惡意軟體,用於竊取錢包檔案、私鑰和助記詞。其多型特性使傳統基於簽章的安全軟體難以偵測。

- 社會工程攻擊:結合AI 產生的話術腳本,攻擊者可在Discord、Telegram 等平台部署機器人,誘導使用者參與虛假NFT 鑄造、空投或投資專案。

- 深度偽造詐騙:配合其他AI 工具,GhostGPT 可用於產生偽造加密專案創辦人、投資人或交易所高階主管的語音,實施電話詐騙或商業郵件入侵(BEC) 攻擊。

Venice.ai:無審查訪問的潛在風險

Venice.ai 提供對多種LLM 的訪問,包括一些審查較少或限制寬鬆的模型。它將自身定位為用戶探索各種LLM 能力的開放門戶,提供最先進、最準確且未審查的模型,以實現真正無限制的AI 體驗,但也可能被不法分子用於生成惡意內容。該平台的風險包括:

- 繞過審查產生惡意內容:攻擊者可藉助平台中限制較少的模型產生釣魚模板、虛假宣傳或攻擊思路。

- 降低提示工程門檻:即便攻擊者不具備高深「越獄」提示技巧,也能輕鬆獲得原本受限的輸出。

- 加速攻擊話術迭代:攻擊者可以利用平台快速測試不同模型對惡意指令的反應,優化詐騙腳本和攻擊手法。

寫在最後

無限制LLM 的出現,標誌著網路安全面臨更複雜、更具規模化和自動化能力的攻擊新範式。這類模式不僅降低了攻擊門檻,也帶來了更隱密、欺騙性更強的新型威脅。

在這場攻防持續升級的博弈中,安全生態各方唯有協同努力,方能應對未來風險:一方面,需要加大對檢測技術的投入,研發能夠識別和攔截惡意LLM所產生的釣魚內容、智能合約漏洞利用和惡意程式碼;另一方面,也應推動模型防越獄能力的建設,並探索水印與溯源機制,以便在金融和代碼生成等關鍵場景中追踪惡意內容來源;此外,還需建立健全的倫理規範與監管機制,從根源上限制惡意模型的開發和濫用。