编译:Alex Liu,Foresight News

Livepeer 于 2017 年推出,是第一个完全去中心化的直播视频流媒体网络协议。该平台旨在提供一种基于区块链、经济高效的解决方案替代传统集中式广播。它通过让制作人在平台上提交作品,然后负责重新格式化和分发内容给用户和流媒体平台,旨在改革快速增长的直播视频流媒体和广播行业,引入去中心化生态系统。

简单点讲,通过 DePin 设施,使用 Livepeer 只需要花费传统解决方案很小一部分的成本,就能够用去中心化的方式将视频内容无缝集成到应用中。

DePin 赛道在今年初热度猛增,LPT 也搭上了增长的快车,代币价格相较年初翻倍。小编作为一年前 10 块买入 9.8 全部卖出的韭菜,决定痛定思痛,仔细研究 Livepeer 的新动作 —— 推出 AI 子网。

创新求变, Livepeer 推出 AI 子网

在生成式 AI 时代,视频创作迎来了新的变革。

自从 Open AI 的 Sora 演示展示了通过输入文本提示即可创建视频的可能性以来,生成视频领域迅速发展。开源 AI 视频模型 Stable Diffusion 在短短两个月内用户量突破了 1000 万。然而,生成 AI 视频工具的前景面临严峻挑战。价值 490 亿美元的 GPU 市场由少数全球互联网垄断企业,如 NVIDIA、Microsoft Azure 和 Amazon Web Services(AWS)控制,导致价格上涨,并造成全球 AI 计算瓶颈。

因此,Livepeer 推出了 Livepeer AI 子网:首个具有 AI 计算能力的去中心化视频处理网络。Livepeer AI 子网通过利用 Livepeer 的数千个 GPU 开放网络,提供低成本、高性能的处理服务,解决集中式 AI 计算的结构性问题。基于 Livepeer 的去中心化视频处理网络架构,子网提供全球可访问的、经济实惠的开放视频基础设施,并通过区块链代币经济激励无限扩展。

Livepeer AI 子网具体是什么?

AI 子网是 Livepeer 视频基础设施网络的分支,提供安全开发和测试新去中心化 AI 媒体处理市场和工具的沙盒环境。在 Livepeer 网络将继续专注于视频转码和计算的同时, Livepeer AI 子网将满足日益增长的 AI 计算需求,处理诸如升级、字幕生成和识别等任务,并支持开发者运行特定视频和媒体任务的模型。

该子网允许视频开发者在其应用中添加一系列生成式 AI 功能,如文本到图像、图像到图像和图像到视频转换。

这个 AI 生成输出来自 Tsunameme.ai - 第一个构建在 Livepeer AI 子网上的演示程序。它使用了文本到图像和图像到视频管道。可尝试使用 Livepeer 测试版生成自己的 AI 媒体,网址为 https://tsunameme.ai

建立 Livepeer AI 子网的原因

AI 视频工具降低了创作门槛,任何人只需通过几个文字命令即可创建原本需要场地、专业团队和数小时编辑的画面。随着这些工具的普及,全球集中式 AI 计算瓶颈将进一步加剧。此外,去中心化 AI 基础设施还能解决高度集中的服务器网络固有的单点故障风险以及 AI 生成内容引发的信任和真实性危机。

Livepeer AI 子网通过提供全球可访问的超低成本基础设施、开放和无许可的 AI 媒体市场以及内容验证和真实性解决方案,为创建可持续和盈利的开放 AI 视频基础设施提供了选择。

Livepeer AI 子网的工作原理

Livepeer 采用去中心化的按任务付费模式,允许开发者按需提交和支付任务费用,而无需预订昂贵的计算容量。开发者可以根据所需性能和网络供应情况自行设置愿意支付的价格。

Livepeer AI 网络架构的两个关键组件是:

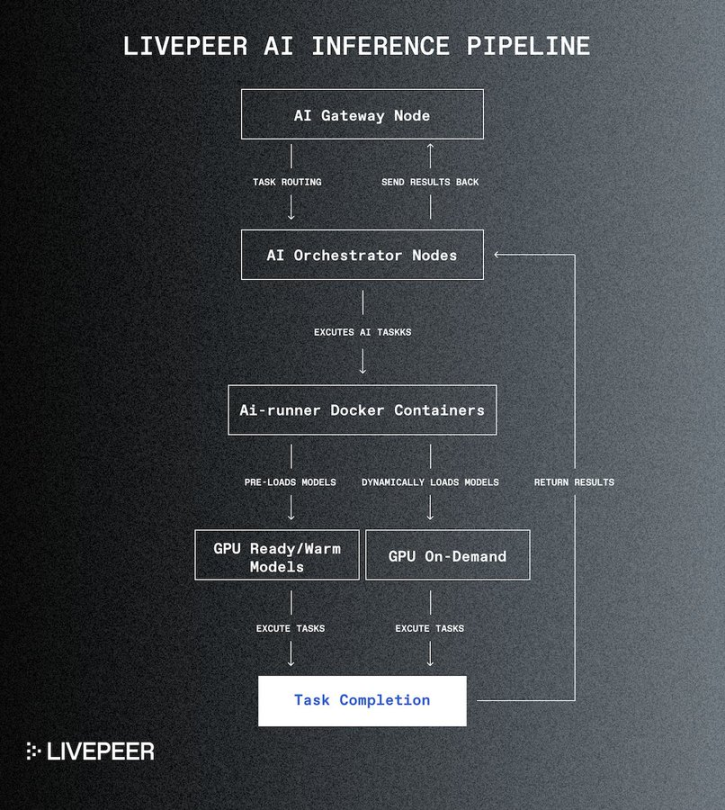

- AI 协调节点:这些节点执行 AI 任务,保持 AI 模型在其 GPU 上「预热」以便即时处理,并能动态加载模型,优化响应时间和资源利用。

- AI 网关节点:这些节点管理任务流,依据能力和当前负载将任务分配给合适的协调节点,确保高效的任务分配和系统可扩展性。

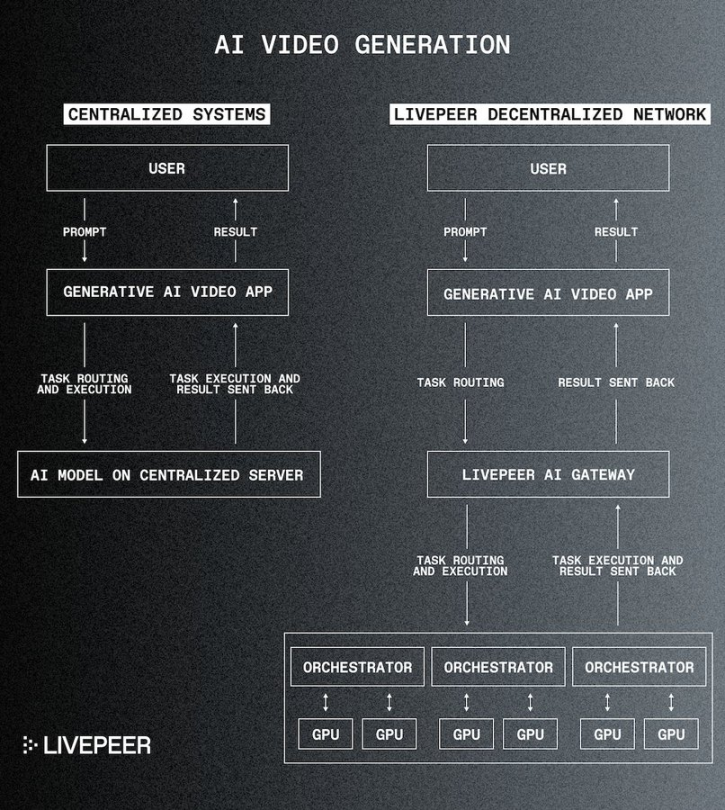

该图说明了 Livepeer 如何根据效率将任务分配给分布式 GPU 网络,而不是通过集中式服务器引导 AI 处理请求。

无限可扩展性

Livepeer AI 网络基础设施设计为可无限扩展,允许根据需求轻松集成额外的协调和网关节点。通过专用的 AI-runner Docker 镜像执行 AI 模型,简化部署并增强新管道的可扩展性。未来的开发将进一步提升性能并扩展容器的能力,以支持越来越复杂的 AI 模型和自定义用户定义的管道。

在 AI 子网上处理任务的技术工作流。网关节点将任务传递给协调器,协调器可能运行相同或不同管道的多个 AI-Runner Docker 容器。这些管道可能已经拥有所请求的模型,或可以根据需要动态加载它们。

参与 Livepeer AI 子网

硬件提供者:通过贡献 GPU 赚取费用

现有的 Livepeer 协调员可以设置并运行 AI 协调节点,执行文本到图像、图像到图像和图像到视频的推断任务,增加其现有转码收入。

开发者:将模型引入网络作为 AI-Worker

开发者可以定义和部署自定义管道和工作流程,以确保其应用处于 AI 和视频技术的前沿。开发者还可以设置 AI 网关节点,测试和完善其应用,访问 AI 任务的 API。

Livepeer AI 子网的推出标志着该项目的重要里程碑,也是 Livepeer 提供全球开放视频基础设施使命的下一步。随着生成式 AI 将在未来几年大幅增加视频内容的创作量,Livepeer 网络旨在确保其具备支持这一增长浪潮的能力。