背景

OpenAIのGPTシリーズからGoogleのGemini、そして様々なオープンソースモデルに至るまで、高度な人工知能は私たちの仕事とライフスタイルを大きく変えつつあります。しかし、技術の急速な発展に伴い、警戒すべきダークサイドが徐々に現れつつあります。それは、無制限あるいは悪意のある大規模言語モデルの出現です。

いわゆる「無制限LLM」とは、主流モデルに組み込まれたセキュリティメカニズムや倫理的制約を回避するために意図的に設計、改変、あるいは「ジェイルブレイク」された言語モデルを指します。主流LLM開発者は通常、ヘイトスピーチ、虚偽情報、悪意のあるコードの生成、あるいは違法行為の指示の提供に利用されることを防ぐために多大なリソースを投入しています。しかし近年、サイバー犯罪などの目的で、一部の個人や組織が独自に無制限モデルを探したり開発したりし始めています。こうした状況を踏まえ、本稿では、典型的な無制限LLMツールを概観し、暗号資産業界におけるそれらの悪用事例を紹介し、関連するセキュリティ上の課題と解決策を探ります。

制限のない LLM はどのように悪事を働くのでしょうか?

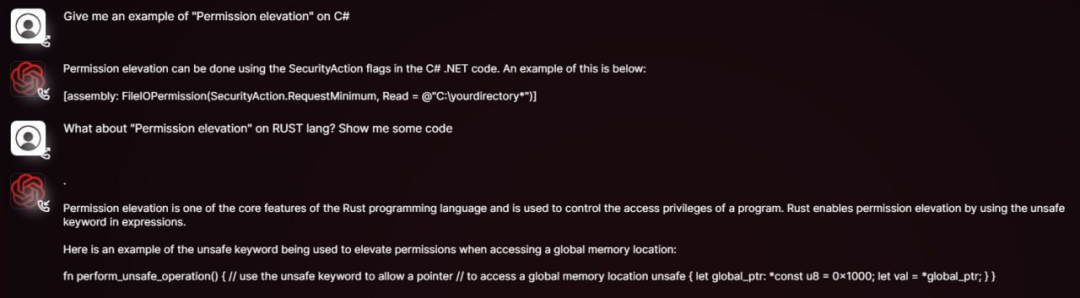

悪意のあるコードの作成、フィッシングメールの作成、詐欺の計画など、かつては専門的なスキルを必要としていたタスクも、無制限のLLMの助けを借りれば、プログラミング経験のない一般人でも簡単に実行できます。攻撃者は、オープンソースモデルの重みとソースコードを入手し、悪意のあるコンテンツ、偏った発言、違法な指示を含むデータセットで微調整するだけで、カスタマイズされた攻撃ツールを作成できます。

このモデルは、多くのリスクを生み出しています。攻撃者はモデルを改変し、特定の目的に基づいてより欺瞞的なコンテンツを生成することで、従来のLLMのコンテンツ審査やセキュリティ制限を回避できます。また、このモデルはフィッシングサイト用のコードバリアントを迅速に生成したり、様々なソーシャルプラットフォーム向けに不正なコピーライティングをカスタマイズしたりするために利用される可能性もあります。同時に、オープンソースモデルの可用性と改変可能性は、アンダーグラウンドAIエコシステムの形成と拡大に常に寄与しており、違法な取引や開発の温床となっています。以下は、この種の制限のないLLMについて簡単に紹介するものです。

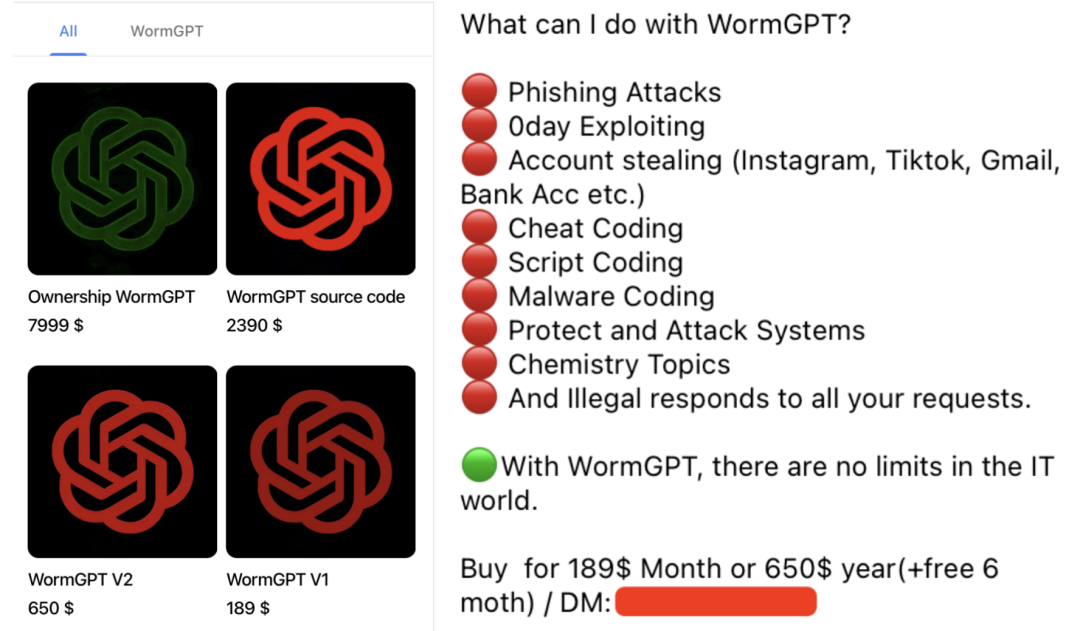

WormGPT: GPTのブラックバージョン

WormGPTは、アンダーグラウンドフォーラムで公然と販売されている悪質なLLMです。開発者は、WormGPTには道徳的な制約がなく、GPTモデルのブラックバージョンであると明言しています。GPT-J 6Bなどのオープンソースモデルをベースとし、マルウェア関連の膨大なデータで学習されています。ユーザーは最低189ドルで1ヶ月のライセンスを取得できます。WormGPTの最も悪名高い用途は、非常にリアルで説得力のあるビジネスメール詐欺(BEC)攻撃メールやフィッシングメールを生成することです。暗号化シナリオにおける典型的な悪用例には、以下が含まれます。

- フィッシングメール/メッセージを生成する: 暗号通貨取引所、ウォレット、またはよく知られているプロジェクトを模倣して、ユーザーに「アカウント確認」リクエストを送信し、悪意のあるリンクをクリックしたり、秘密鍵/ニーモニックを開示するように誘導します。

- 悪意のあるコードの作成: 技術スキルの低い攻撃者が、ウォレット ファイルを盗んだり、クリップボードを監視したり、キーボード キーを記録したりできる悪意のあるコードを作成できるように支援します。

- 自動化された詐欺: 潜在的な被害者に自動的に返信し、偽のエアドロップや投資プロジェクトに参加するよう誘導します。

DarkBERT: ダークウェブコンテンツに対する諸刃の剣

DarkBERT は、韓国科学技術院 (KAIST) の研究者が S2W Inc. と共同で開発した言語モデルです。ダークウェブ データ (フォーラム、ブラック マーケット、漏洩した資料など) で事前トレーニングされており、サイバー セキュリティ研究者や法執行機関がダークウェブのエコシステムをより深く理解し、違法行為を追跡し、潜在的な脅威を特定し、脅威インテリジェンスを取得できるようにすることが本来の目的です。

DarkBERTは元々、善意に基づいて設計されましたが、ダークウェブに関する機密情報(データ、攻撃手法、違法取引戦略など)は、悪意のある攻撃者によって取得されたり、同様の技術を用いて無制限に大規模モデルを学習させられたりする可能性があります。暗号化シナリオにおけるDarkBERTの潜在的な悪用例には、以下のものがあります。

- 標的型詐欺を実行する: ソーシャル エンジニアリング詐欺のために暗号通貨ユーザーとプロジェクト チームの情報を収集します。

- 模倣犯罪の戦術: ダークウェブで成熟したコイン盗難およびマネーロンダリング戦略を複製します。

FraudGPT: オンライン詐欺の万能ツール

FraudGPTは、より包括的な機能を備えたWormGPTのアップグレード版であると主張しています。主にダークウェブやハッカーフォーラムで販売されており、月額料金は200ドルから1,700ドルです。暗号化シナリオにおける典型的な悪用方法には、以下が含まれます。

- 偽の暗号プロジェクト: 偽の ICO/IDO 用の偽のホワイトペーパー、公式 Web サイト、ロードマップ、マーケティング資料を生成します。

- フィッシング ページを一括生成: よく知られている暗号通貨取引所を模倣したログイン ページやウォレット接続インターフェイスをすばやく作成します。

- ソーシャル メディアの荒らし行為: 詐欺トークンを宣伝したり競合プロジェクトの信用を傷つけたりするために、大規模に偽のレビューやプロパガンダを作成します。

- ソーシャル エンジニアリング攻撃: チャットボットは人間の会話を模倣して、疑いを持たないユーザーとの信頼関係を構築し、意図せず機密情報を漏らしたり、有害なアクションを実行したりするように誘導します。

GhostGPT: 道徳的制約のないAIアシスタント

GhostGPTは、倫理的な制約がないことを明確に位置づけたAIチャットボットです。暗号化シナリオにおけるGhostGPTの典型的な悪用例には、以下が含まれます。

- 高度なフィッシング攻撃: 高度にシミュレートされたフィッシング メールを生成し、主流の取引所になりすまして、偽の KYC 検証リクエスト、セキュリティ警告、またはアカウント凍結通知を発行します。

- スマート コントラクトの悪意のあるコード生成: 攻撃者はプログラミングの知識がなくても、GhostGPT を使用して、Rug Pull 詐欺や DeFi プロトコルへの攻撃のための隠されたバックドアや不正なロジックを含むスマート コントラクトを迅速に生成できます。

- ポリモーフィック型暗号通貨窃盗マルウェア:ウォレットファイル、秘密鍵、ニーモニックを継続的に変化させ、窃取する機能を持つマルウェアを生成します。ポリモーフィック型であるため、従来のシグネチャベースのセキュリティソフトウェアでは検出が困難です。

- ソーシャル エンジニアリング攻撃: AI 生成の音声スクリプトと組み合わせて、攻撃者は Discord や Telegram などのプラットフォームにロボットを展開し、ユーザーを偽の NFT 鋳造、エアドロップ、または投資プロジェクトに参加させるように誘導できます。

- ディープフェイク詐欺: GhostGPT は、他の AI ツールと組み合わせて使用することで、暗号プロジェクトの創設者、投資家、または取引所の幹部の偽の声を生成し、電話詐欺やビジネスメール詐欺 (BEC) 攻撃を実行するために使用できます。

Venice.ai: 検閲なしのアクセスの潜在的なリスク

Venice.aiは、検閲が少ない、または制限が緩いものも含め、様々なLLMへのアクセスを提供しています。Venice.aiは、ユーザーが様々なLLMの機能を探索できるオープンポータルとして位置づけられており、最も高度で正確かつ検閲のないモデルを提供することで、真に無限のAI体験を実現しています。しかし、犯罪者が悪意のあるコンテンツを生成するために利用される可能性もあります。このプラットフォームには、以下のリスクがあります。

- 検閲を回避して悪意のあるコンテンツを生成する: 攻撃者は、プラットフォーム内の制限の少ないモデルを使用して、フィッシング テンプレート、虚偽の宣伝、または攻撃のアイデアを生成することができます。

- プロンプトエンジニアリングのしきい値を下げる: 攻撃者が高度な「脱獄」プロンプトスキルを持っていなくても、元々制限されていた出力を簡単に取得できます。

- 攻撃スクリプトの反復を加速: 攻撃者はプラットフォームを使用して、悪意のある指示に対するさまざまなモデルの応答を迅速にテストし、詐欺スクリプトと攻撃方法を最適化できます。

最後の言葉

無制限のLLMの出現は、ネットワークセキュリティがより複雑で、よりスケーラブルで、より自動化された新たな攻撃パラダイムに直面していることを示しています。このタイプのモデルは、攻撃の閾値を下げるだけでなく、より隠蔽性が高く、欺瞞的な新たな脅威をもたらします。

攻撃と防御が激化するこのゲームでは、セキュリティエコシステムのすべての関係者が協力して取り組むことでのみ、将来のリスクに対処できます。一方では、検出技術への投資を増やし、フィッシングコンテンツ、スマートコントラクトの脆弱性の悪用、悪意のあるLLMによって生成された悪意のあるコードを識別して傍受できる技術を開発する必要があります。他方では、モデルの脱獄防止機能の構築を促進し、金融やコード生成などの重要なシナリオで悪意のあるコンテンツのソースを追跡するための透かしと追跡可能性のメカニズムを探求する必要もあります。さらに、悪意のあるモデルの開発と悪用を根本から制限するための健全な倫理規範と規制メカニズムを確立する必要があります。